Development of a molecular marker for sex identification of Spodoptera frugiperda

-

摘要:目的

开发用于草地贪夜蛾Spodoptera frugiperda性别鉴定的分子标记引物。

方法依据草地贪夜蛾雌、雄虫性信息素结合蛋白(Pheromone-binding protein, PBP)基因片段序列的差异设计特异性性别鉴定引物;利用引物对经过形态学鉴定的草地贪夜蛾雌、雄样本进行PCR验证。

结果2对引物分别对对应的雌、雄虫样本均扩增出450 bp左右的特异性条带。

结论开发的分子标记引物可以快速有效地对各个时期的草地贪夜蛾进行性别鉴定,为研究草地贪夜蛾雌、雄个体差异提供一种有效工具。为制定基于性别鉴定的草地贪夜蛾的有效治理防控策略提供参考。

Abstract:ObjectiveTo develop molecular marker primers for sexual identification of Spodoptera frugiperda.

MethodBased on the difference in pheromone-binding protein (PBP) gene sequences of male and female S. frugiperda, the primers were designed for distinguishing sexual distinction specifically. Using the primers, the male and female S. frugiperda samples already identified by morphology were further verified by PCR.

ResultSpecific bands of about 450 bp for the corresponding female and male samples were amplified by two pairs of primers respectively.

ConclusionThe molecular marker primers can be used to discriminate the sex of S. frugiperda in various developmental stages efficiently, and provide an effective tool for the study of the individual distinction between different sexual insects. This study provide a reference for formulating the strategy to control S. frugiperda effectively based on sexual distinction.

-

我国是世界第一荔枝生产大国,种植面积和产量分别约占全世界的80%和65%以上,荔枝栽培历史悠久,品种资源和生产经验丰富,其中,广东省是我国荔枝种植大省。荔枝的花量通常都偏多,尤其是大花穗品种,1个花穗其小花量可达数千朵,荔枝常年花量偏大,消耗的养分过多反而影响坐果[1]。荔枝花期的现白点时间、花穗数量、花量、雄花数、雌花数、开花时间、谢花时间等指标要素对荔枝生产精准管理格外重要。根据果树花期长势监测结果,在修剪促萌、灌水、环割作业时间或药剂处理上进行精准控制,以实施精准促花壮花或疏化保花等措施,有利于提高坐果率。近年来,多项研究表明,在花期进行合理的管控有利于果实产量与品质的提升,如疏花加快了无核荔枝果实生长发育,并提高了果实的产量和品质[2]。在花穗生长中期修剪花穗,能明显提高单穗挂果数和产量,综合效果最好[3]。通过“一疏二控三割”控穗疏花技术可以显著提高‘妃子笑’的最终坐果率、株产和果实固酸比[4]。不同程度的疏花方式均能够显著减少花量,缩短开花时期,并增加坐果量[5]。疏花可以提高单个花穗的雌花比例,提前一批雄花和第一批雌花的开放高峰,延长雌花的持续开放时间,进而增加初始坐果量,降低生理落果[6]。此外,随着荔枝种植规模的扩大,人力成本越来越高,基于无人机遥感的大面积果园果树花期长势的智能监测需求日益增加。

近距离拍摄荔枝花的图像,并利用计算机视觉和机器学习的方法进行花期识别和诊断,是目前主流的研究方法。Wang等[7]提出夜间环境下修正的芒果花分割方法,该方法将拍摄效果好的图像作为参照图像,使用归一化放缩法将其他图像灰度放缩到参照图像的灰度范围内,从而起到修正作用。用固定的阈值分割出芒果花、叶片和枝干后,训练识别花的支持向量机,精确分割出芒果花,并计算花密度,其准确率达到85. 8%。Yousefi等[8]得出基于随机森林的油棕榈开花期分类模型在准确率和F度量值(F-measure)方面要高于K最近邻算法 (K-nearest neighbor,K-NN)和支持向量机 (Support vector machine,SVM)算法,证明了利用随机森林模型对油棕榈开花期4个阶段进行分类的可行性,随机森林模型的阶段分类准确率可以达到72.36%。Lu等[9]通过摄像头进行柑橘开花率评估,利用MobileNetv3作为特征提取器,结合深度可分离卷积进一步加速,改进的柑橘开花率统计模型均值平均精度(Mean average percision,mAP)为84.84%,在保证一定精度的前提下,具有内存占用少、检测速度快等优点。朱永宁等[10]提出结合枸杞开花期和果实成熟期的植物学特征,利用Faster R-CNN方法对图像进行训练、分类,构建枸杞开花期和果实成熟期的识别算法,mAP达到74%。杨其晟等[11]提出一种改进 YOLOv5 的苹果花朵生长状态检测方法,对花蕾、半开、全开、凋落这4类苹果树开花期花朵生长状态进行检测。该方法首先对跨阶段局部网络模块进行改进,并调整模块数量,结合协同注意力模块设计主干网络,提高模型检测性能并减少参数,mAP达到92.2%。熊俊涛等[12]提出一种基于深度语义分割网络识别荔枝花、叶片像素并实现分割的方法,构建深度为34层的ResNet 主干网络,引入稠密特征传递方法和注意力模块,提取荔枝花、叶片的特征;最后通过全卷积网络层对荔枝花、叶片进行分割,模型的平均交并比(Mean intersection over union,mIoU)为0. 734,像素识别准确率达到 87%。邓颖等[13]提出基于实例分割的柑橘花朵识别与花量统计方法,以花期的柑橘树冠图像为样本进行花朵实例的识别及分割,通过对 Mask R-CNN 主体卷积部分和掩膜分支部分的优化,实现对复杂结构图像中密集小尺度柑橘花朵目标的高效检测,获取图像中可见花数量识别神经网络的平均精度为 36.3,花量计算误差为 11.9%。

随着无人机行业的发展,低空遥感已经开始应用于农业农事的判断和管理,无人机低空遥感相比于地面摄像头和人工采集图像,可以获得更加丰富的农作物和地理信息,相比于卫星遥感具有获取方式更灵活、时效高、影像分辨率高等特点,在农情监测、精准农业等领域得到越来越多的应用[14-17 ]。杜蒙蒙等[18]在小麦分蘖期内获取可见光波段的无人机遥感图像,建立植被指数与小麦茎蘖密度地面真值之间的预测模型,在田块尺度上定量反演小麦茎蘖密度,小麦茎蘖密度定量反演BP神经网络模型的均方根误差及平均绝对百分比误差分别为19%及3.62%,具有较高的小麦茎蘖密度预测精度。朱圣等[19]通过获取水稻田的低空遥感图像,分析得到杂草分布图,构建CNN网络对图像的分类,精度达到 92.41%,生成的水稻田杂草分布图效果最好。杨蜀秦等[20]提出一种改进的玉米雄蕊识别模型,能够准确地检测无人机遥感图像中尺寸较小的玉米雄蕊,检测精度分别比Faster R CNN 和YOLO v4模型高26. 22%和3. 42%,为玉米抽雄期的农情监测提供参考。

综合研究表明,目前大多通过地面摄像头和人工手持相机采集荔枝花数据,由于角度受限,导致地面拍摄的花期信息不够全面,无法应用于大规模荔枝园。由于荔枝花主要集中在冠层,侧面花较少,且荔枝树均较高,人工观测荔枝冠层耗时长、收效低,因此利用无人机拍摄冠层可以获取更多荔枝花期的信息,同时能够节省部分人力和物力,一定程度上可以提升农业农事的效率。兰玉彬教授研究团队在基于无人机遥感技术进行果树大面积智能监测方面,积累了较好的研究经验,Mo等[21]从无人机获取的图像中对果树冠层进行实例分割,对于果园的精准管理具有重要意义;李继宇等[22]基于文献计量学,得出农用无人机仍处于活跃的发展阶段,应用场景日趋丰富,纵向发展稍有阻滞,未来可能会在畜牧业和渔业上挖掘到新的研究应用方向。现有的研究鲜见通过荔枝冠层进行观测分析,本研究拟采用大疆精灵P4 Multispectral无人机采集荔枝花期冠层数据,重点优选和优化荔枝开花率评估分类模型,并建立更加精准的荔枝花期长势评估模型,以期为后续荔枝花期疏花保果、精准施肥施药提供决策依据。

1. 材料与方法

1.1 研究区域

研究区域位于广东省广州市从化区荔博园(23°58′N,113°62′E),如图1a所示,该区域属亚热带季风区,气候温和,雨量充沛,全年平均气温22.0 ℃,年降雨量2305.1 mm,年日照1638.0 h,适宜的温度、肥沃的土壤共同组成了荔枝生长的理想环境。

1.2 图像采集与数据集构建

采用大疆精灵P4 Multispectral拍摄园区荔枝树冠层可见光图像,该无人机采用TimeSync时间同步系统,通过将飞控、相机与RTK的时钟系统进行微秒级同步,实现相机成像时刻的毫秒级误差。系统还对每个相机镜头中心点位置与天线中心位置,结合设备姿态信息,进行实时补偿,使影像获得更加丰富的位置信息。本研究于2021年2月底至3月底拍摄园区花期荔枝冠层,飞行高度约45 m,飞行速度约5 m/s,结合地面站软件 DJI GS PRO 进行航线规划。园区占地面积约20 hm2,拍摄园区荔枝共141棵,通过大疆制图软件对获取图像进行拼接。拼接后图像分辨率为10863像素×10974 像素,试验基地荔枝冠层俯拍图如图1b所示。

为获得单棵荔枝冠层图像,将整张园区冠层图像首先进行分块处理,再运用YOLACT实例分割模型对园区内的冠层进行分割,网络训练优化器为随机梯度下降(Stochastic gradient descent,SGD),学习率为0.001,权重衰减为5×10−4 ,动量因子为0.9,分割最佳精确度(Average precision,AP)达到96.25%,模型推理结束后对图像进行合并处理,去除冗余重复的部分,并结合图片中每棵树的位置信息,拼接后最终获得单棵荔枝树的冠层图像[22],冠层分割效果如图2所示。综合地面调查,结合园艺专家的综合判断,对每棵冠层图像标记开花率,标注的开花率分别为0、10%~20%、50%~60%、80%及以上,对应荔枝花期的未开花、分化、初花、盛花期:将开花率为0%的冠层图像定为第0类即未开花;开花率10%~20%的冠层图像定为第1类,即分化;开花率50%~60%的冠层图像定为第2类,即初花期;开花率80%及以上的冠层图像定为第3类,即盛花期。得到565张荔枝原始冠层图像,按照6︰2︰2比例随机划分训练集、验证集和测试集。遥感图像开花率示例如图3所示。

1.3 数据集增强

在已有训练集的基础上,在训练过程中利用PyTorch框架进行多项数据增强,包括随机裁剪、垂直翻转、水平翻转、随机旋转一定角度,可以在训练过程中扩充数据集,增加数据的多样性,提升深度学习的鲁棒性,使得模型学习更加全面。数据增强效果如图4所示。

1.4 开花率评估模型构建

1.4.1 深度卷积神经网络

ResNet网络[23]参考了VGG19网络,在其基础上进行了修改,并通过短路机制加入了残差单元解决退化问题,根据研究得出,随着层数的增加,ResNet的精度随之增加,同时计算复杂度也随之增加。后续提出的多维残差网络(Next dimension resNet,ResNeXt)[24]在网络结构上对ResNet 进行了改进,借鉴了Inception分组[25]的思想,区别于Inception需要人工设计每个分支,ResNeXt的每个分支拓扑结构是相同的,通过多分支卷积网络(Multi-branch convolutional networks)、分组卷积(Group convolution)结构在不明显增加参数量级的情况下提升模型的准确率,同时由于拓扑结构相同,超参数减少,便于模型移植。

ShuffleNetv1[26]是一个可用于移动设备的轻量级卷积神经网络,在ResNet的基础上改进,其中Channel shuffle解决了多个分组卷积(Group convolution)叠加出现的边界效应,借鉴了MobileNet的深度可分离卷积、逐点组卷积(Pointwise group convolution)和深度可分离卷积(Depthwise separable convolution),主要减少了计算量,可以在有限的算力之下实现最优精度,更加适用于高时效、低延迟的场景。ShuffleNetv2[27]中提出了FLOPs不能作为衡量目标检测模型运行速度的标准,ShuffleNetv1大量使用1×1组卷积增加了内存访问成本(Memory access cost),同时使用过多的组会造成网络碎片化,减少模型的并行度。为了弥补ShuffleNetv1的缺陷引入了通道分割(Channel split),将1×1组卷积修改为1×1卷积,将2个分支的输出连接在一起,紧接着将2个分支连接的结果进行Channle shuffle,以保证2个分支信息交流,模型基本单元结构如图5a所示。下采样模块不再用Channel split,2个分支都直接复制1份输入,分支均采用步长为2的卷积层进行下采样,接着增加1个 1×1 卷积进行通道数的调整,最后将2个分支进行合并,特征图空间大小减半、通道数翻倍,空间下采样单元结果如图5b所示。

1.4.2 基于ShuffleNetv2的改进模型

作为轻量级网络,ShuffleNetv2复杂度比ResNet和ResNeXt都低,且适用场景更广,所以选取ShuffleNetv2作为本研究的基础网络模型。ShuffleNetv2的整体结构如图6所示。

本研究在ShuffleNetv2基础上,对尾部结构进行了修改,即将网络最后全连接层1000个类别改为4类,剔除不需要的参数,减少参数量,选取较大的学习率,能够更好地学习拟合本研究的数据,达到更好的效果。训练过程中运用迁移学习的方法,即以在ImageNet数据集训练得到的权重作为本研究的预训练权重,该项操作有助于新模型的训练,避免随机初始化权重导致训练的效果不好、训练时间过长,通过预训练能够使得网络更好地拟合。

此外,CBAM(Convolutional block attention module)是一种轻量型的模块,作为即插即用的模块能够集成到现有的网络中,且能够节约参数和算力,在ResNet和MobileNet中均取得了不错的效果,其中的空间注意力模块(Spatial attention module,SAM)[28]使得网络主要集中学习特征图中的位置信息。因此,本研究在ShuffleNetv2网络结构中加入SAM。SAM的运行流程是将输入的特征图进行基于通道的全局最大池化(Global max pooling)和全局平均池化(Global average pooling),然后将得到的2个结果进行基于通道的连接(Conact)操作。基于通道的操作可以有效地突出信息区域,经过1个卷积操作,降维后得到1个通道的特征图,再经过Sigmod函数生成空间特征图(Spatial attention feature),最后将得到的特征图和该模块的输入特征图进行相乘,得到最终生成的特征,如图7所示。

本研究加入的SAM的计算公式如下:

$$\begin{split} {\rm{Ms}}(F)& = \sigma \left\{ {{f^{7 \times 7}}\left[{\rm{AvgPool}}(F);{\rm{MaxPool}}(F)\right]} \right\}\\ & = \sigma \left[{f^{7\times 7}} \left( {{F_{{\rm{avg }}}^{\rm{s}}};F_{{\rm{max }}}^{\rm{s}}} \right)\right]\end{split}$$ (1) 式中:Ms(F)为计算得到的特征;σ为Sigmoid的函数;f 7×7 表示卷积核尺寸是7×7;

${F_{{\rm{avg }}}^{\rm{s}}} $ 、$F_{{\rm{max }}}^{\rm{s}}$ 表示最大池化和平均池化操作。在ShuffleNetv2网络结构中加入SAM,本研究进行多次试验得到加入SAM的最佳位置,即在阶段2后加入SAM。改进后的网络模块如图8所示。

2. 结果与分析

2.1 试验环境

本试验使用的服务器处理器为Intel Core i7-10700 CPU @ 2.90GHZx 16,内存16 GB,显卡为GeForce GTX 3070。软件方面,系统为Ubuntu16.04,CUDA 版本为11.3。基于Python编程语言使用PyTorch框架进行深度学习模型的搭建。

2.2 评价指标

本研究所用的测试指标主要为准确率和损失值。准确率广泛地应用于分类的评估中,准确率是指预测正确的样本数占全部总样本数的比例,针对的是所有样本的统计量,计算较为简单,在分类问题中是最直观的评价指标。

$$ {\rm{Acc}} = \dfrac{{\rm{TP}}+{\rm{TN}}}{{\rm{TP}}+{\rm{FP}}+{\rm{FN}}+{\rm{TN}}} , $$ (2) 式中,Acc表示准确率,TP表示判断正确的正例数,TN 表示判断正确的负例数,FP 表示判断错误的正例数,FN 表示判断错误的负例数。

训练模型时使用交叉熵损失函数来训练优化本研究模型参数,损失函数的公式如下:

$$ \mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}=-\displaystyle\sum\limits _{i=0}^{{F}_\mathrm{c}}{{y}}_{i}\mathrm{log}{{y}}_{\mathrm{p}\mathrm{r}\mathrm{e}\_i} \text{,} $$ (3) 式中,Loss表示损失值,

${{y}}_{\mathrm{p}\mathrm{r}\mathrm{e}\_i}$ 表示输入数据的类是第i类的概率,i 表示样本标签即真实值,Fc表示类的总数量。2.3 模型训练

针对荔枝冠层花期遥感图像,进行花期评估,本研究进行多项对比试验,将改进后的ShuffleNetv2与深度学习卷积神经网络ResNet18、ResNet34、ResNet50和ResNeXt50进行多方面的对比。均采用迁移学习的方法,加载预训练的权重,模型训练迭代次数为50次,批处理尺寸为32,损失函数为对数交叉熵损失(Cross entropy loss),优化算法为随机梯度下降(Stochastic gradient descent,SGD) 。动态调整学习率,动量因子为 0. 9,其中ShuffleNetv2属于轻量型网络,相对本研究其他网络较小,ShuffleNetv2和改进后的ShuffleNetv2初始学习率设定为0.1,能够更快地拟合本研究数据,拟合效果更好,其余对比模型较大,学习率过大会造成网络无法收敛,在最优值附近振荡,初始学习率设定为0.001。

2.4 对比分析

图9为本文改进的ShuffleNet v2模型与其他5种主流深度学习卷积神经网络模型的损失值变化曲线的比较。由图9a可以看出,ShuffleNetv2在训练集上损失值降低得较快。损失值可以很好地反映模型的拟合能力,损失越低表示模型拟合能力越强,其中,ResNet18层数过浅导致学习特征不够,模型拟合效果欠佳,而ShuffleNetv2和改进后的ShuffleNetv2最终达到较小的损失值,表明ShuffleNetv2对荔枝花期冠层的特征提取能力强,模型表征充分,和ResNet50、ResNeXt50相比,损失值相差很小。由图9b可以看出,ResNet50损失值最终在0.55左右,ResNeXt50损失值维持在0.51左右,改进后的ShuffleNetv2在验证集上损失值波动很小且达到最低,维持在0.49左右,证明相比其他模型该模型泛化能力强。

由图10a可以看出,在训练集上,ShuffleNetv2和改进后的ShuffleNetv2准确率均高于ResNet,与ResNeXt准确率十分接近。由图10b可以看出,在验证集上,ResNet50的准确率达到0.78左右,ResNeXt50的准确率达到0.80左右,ShuffleNetv2和改进后的ShuffleNetv2准确率分别达到0.83和0.84左右,效果比ResNet、ResNeXt好,表明模型学习效果较好。

表1为不同模型对荔枝开花率评估的性能对比。由表1可知,随着层数的增加,ResNet训练时间延长;ShuffleNetv2的训练时间相比于ResNet18较少。与ResNet、ResNeXt网络相比,ShuffleNetv2的训练速度大幅提高,将有利于后期补充新的数据集,更加迅速地拟合。在单张验证的时间上,ShuffleNetv2和改进的ShuffleNetv2都要比ResNet34短,体现出一个轻量型网络在验证速度上的优势。在测试集上,改进后的ShuffleNetv2模型能够准确地分类出不同花期的冠层,可以准确分析出所处花期为哪一类,尤其是第1类(开花率10%~20%)和第2类(开花率50%~60%)识别效果相比ResNet、ResNeXt有大幅提升。ResNet、ResNeXt模型效果不如改进后的ShuffleNetv2,主要识别错误集中在第2类上,第2类上ResNet34识别准确率只能达到52%,误判率较高,因为第1类和第2类荔枝冠层的花期特征十分接近,所以模型识别困难,本研究关键难点也在于此,改进后的ShuffleNetv2在保持第0类(开花率0%)和第3类(开花率80%及以上)高准确率的基础上,大大提升了第2类的准确率,第2类识别准确率可以达到68%,相比于ResNet、ResNeXt高出约8个百分点,模型整体的识别准确率提升,可以为后期果园精准管控提供参考。

表 1 不同模型的性能对比Table 1. Performance comparison of different models模型 Model t训练/s Training time t验证/ms Validation time 分类准 确率/% Classification accuracy 2类准 确率/% Category 2 accuracy ResNet18 120.4 7.352 83.33 60.0 ResNet34 135.8 7.812 83.33 52.0 ResNet50 175.6 8.802 85.96 60.0 ResNeXt50 199.2 9.116 87.01 60.0 ShuffleNetv2 114.4 7.529 86.84 64.0 改进的 ShuffleNetv2 109.0 7.507 88.60 68.0 Improved ShuffleNetv2 图11为不同网络模型用于评估荔枝开花率的参数量比较。由图11可知,随着层数的增加,ResNet参数量成正比增加,数量级都很大;ResNeXt50相对于ResNet50,参数量有所减少,因为ResNeXt50引入了分组卷积,使得参数减少的情况下效果更好,减少了超参数的数量。ShuffleNetv2的参数量相对ResNet和ResNeXt要少很多,比最少的ResNet18的参数少10866148,而识别效果要好很多。ShuffleNetv2和ResNeXt50相比,参数量相差达到23167106,效果略差一点,改进后的ShuffleNetv2参数量与ShuffleNetv2几乎没有区别,但是识别效果有了较大的提升。荔枝冠层模型分类的最终效果如图12所示。

3. 讨论与结论

3.1 讨论

本研究的荔枝花期遥感图像数据中,单棵荔枝冠层图像分辨率均较低,经过与ResNet、ResNeXt大量的对比试验发现,较深的卷积神经网络应用于本试验,会出现冠层特征消失、过拟合等问题,网络层数过多且没有明显地提升准确率,训练和识别速度比较慢,所以ResNet、ResNeXt网络不适用于本研究。在同样的参数设定下,轻量级网络ShuffleNetv2对本研究数据有着较好的拟合效果,未优化时准确率已达到86.84%,与ResNeXt50相差0.17个百分点,且ShuffleNetv2的训练时间、验证时间有着绝对的优势,参数量最少。试验过程中发现,荔枝冠层花期第2类(开花率50%~60%)误判率最高,识别精度难以有效提升,相比于ResNet、ResNeXt一贯地依靠增加网络层数来提升精度,ShuffleNetv2的基础单元中加入了Channle split,能够巧妙地有效学习第2类花期冠层的特征,且能够保持冠层特征不会消失。

将ShuffleNetv2进行主体结构优化,在阶段2后加入SAM模块,使得网络学习过程中注意面增宽,更加注意输入图像的位置信息,能够对荔枝冠层遥感图像进行更加精准的学习,更加关注荔枝冠层花的位置信息,从而能够更好地判断和识别花期所属的类别,进一步提升网络的泛化性和识别准确率,改进后的ShuffleNetv2分类准确率相比未优化的ShuffleNetv2提升1.76个百分点,相比ResNeXt50提升1.59个百分点,最终能达到88.60%,且参数量和未优化的ShuffleNetv2相差甚微。在增加空间注意力模块和优化主干网络以后,训练时间反而会降低,因为模型更加关注荔枝花的部分,重点学习荔枝冠层的各项特征,有效剔除掉与花期无关的信息,所以训练速度会变快。本研究可以应用于大型荔枝园的花期评估,可以在很大程度上节省人力、物力和财力。方法上充分运用了迁移学习,节省了训练时间,能够充分地学习到冠层花期的特征。

3.2 结论

本文使用无人机采集荔枝冠层的可见光遥感图像,将遥感图像以实例分割的方法进行有效的冠层分割,得到单独每棵荔枝冠层的图像,将图像预处理后送入分类网络中。由于荔枝花期特征较为接近,识别较为困难,通过无人机获取遥感图像,在独特的视角下进行花期的分类。加入空间注意力模块,改进后的ShuffleNetv2能够挖掘学习更为细节的荔枝冠层花期信息,不仅具有较高的识别精度,而且有着很快的训练和识别速度,对荔枝花期的评估有很大的优势。

本研究对荔枝冠层的遥感图像进行处理,实现了大型荔枝园的花期评估,同时降低了计算成本,具有很强的实时性,为荔枝花期的花量提供数据支撑,在荔枝研究领域有着很高的实用价值。同时本研究结果可以更好地被应用与推广,可以在不显著要求算力的情况下进行模型的推理,本研究的方法为其他种类果树的花期评估提供了一个新思路,利用轻量级网络对无人机拍摄的冠层图像进行花期的研究与评估。未来可以加入不同地区的果树冠层数据,提升数据的多样性,并结合地面摄像头数据,进一步提升模型识别效果。将模型精简后部署到边缘智能终端,节约算力资源,可以在无人机拍摄过程中,更快地实现花期的判断。

-

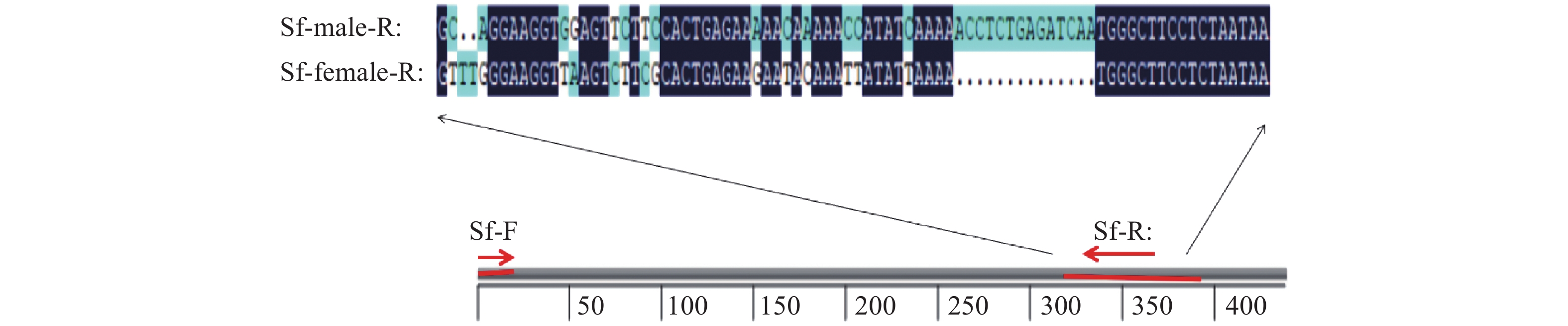

图 1 草地贪夜蛾性别鉴定引物设计

深蓝色表示相同的核苷酸序列,浅蓝色表示差异位点,黑点表示缺失位点;Sf-male-R:雄虫基因差异区段;Sf-female-R:雌虫基因差异区段;Sf-F:正向引物;Sf-R:反向引物

Figure 1. Primers design for sexual identification of Spodoptera frugiperda

Dark blue represents the same nucleotide sequence, light blue represents the differencial sites and black dots represent the missing sites; SF-male-R: Differential gene segment of male; Sf-female-R: Differential gene segment of female; Sf-F: Forward primer; Sf-R: Reverse primer

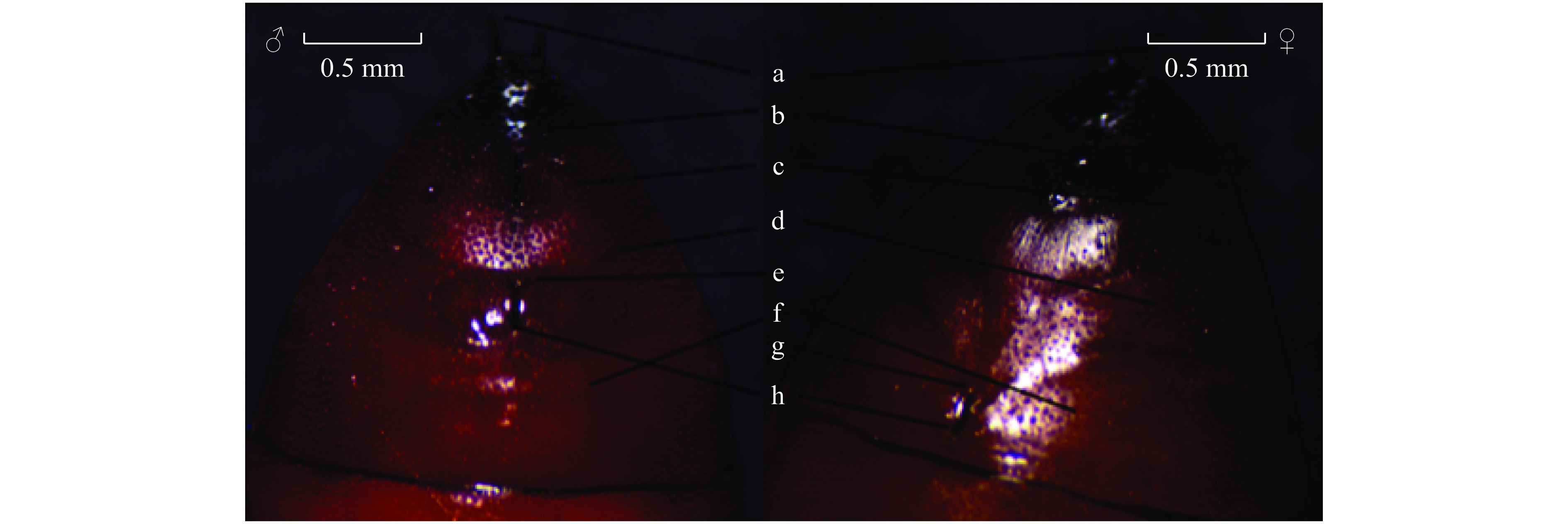

图 2 草地贪夜蛾蛹期雌、雄虫腹部末端差异对比

a:臀刺;b:肛门;c:第10腹节;d:第9腹节e:半圆形瘤状突起;f:第8腹节;g:产卵孔;h:生殖孔

Figure 2. Distinction between abdomen ends of male and female of Spodoptera frugiperda at pupal stage

a: Buttocks stab; b: Anus; c: The 10th abdominal segment; d: The 9th abdominal segment; e: Semicircular tumor-like protrusion; f: The 8th abdominal segment; g: Spawning hole; h: Genital hole

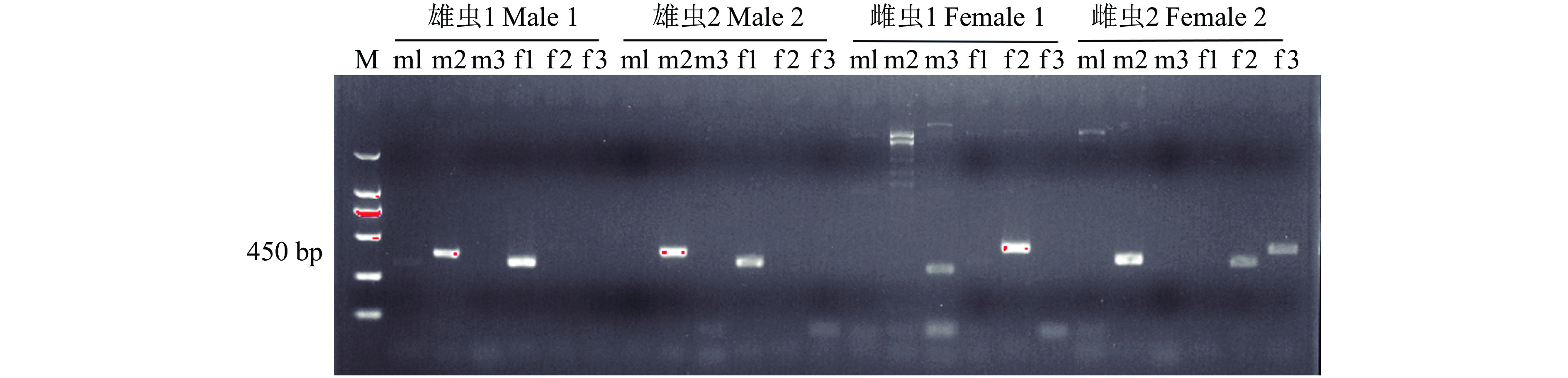

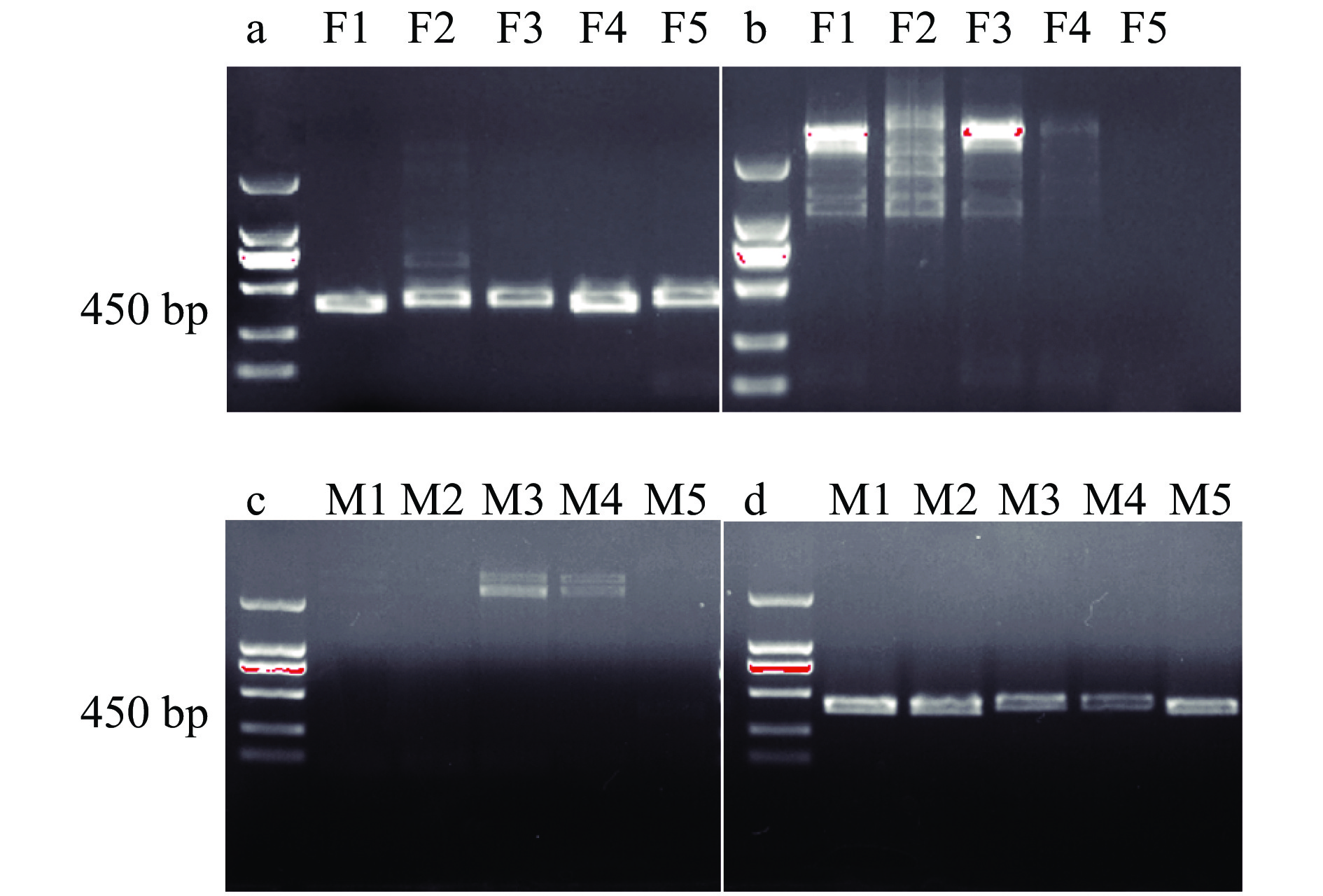

图 4 基于PCR扩增对草地贪夜蛾雌、雄虫蛹性别鉴定

F1~F5:雌虫蛹DNA;M1~M5:雄虫蛹DNA;a、c:雌虫标记引物对 Sf-F/Sf-female-R-2;b、d:雄虫标记引物对Sf- F/Sf-male-R-2

Figure 4. Sex identification of male and female pupae of Spodoptera frugiperdabased on PCR amplification

F1−F5: DNA of female pupae; M1−M5: DNA of male pupae; a and c: Pair of female marker primers of Sf-F/Sf-female-R-2; b and d: Pair of male marker primers of Sf-F/Sf-male-R-2

表 1 引物序列表

Table 1 List of primer sequence

引物名称1) Primer name 引物序列(5′→3′) Primer sequence Sf-F TAGCCGTGAGTTTGAATAGGGT Sf-female-R-1 CCTGCCAGTGCCTTATTAATTAA Sf-male-R-1 TTTTGGCAGTGCCTTATTGATTA Sf-female-R-2 CTCAGAGGTTTTTGATATGGTTT Sf-male-R-2 TGTATTCTTCTCAGTGCGAAGAC Sf-female-R-3 TTAACAACGCTCCATAATAACCT Sf-male-R-3 TAAGAACCAGTTCTTATAAACAC 1) F、R分别表示正、反向引物

1) F and R respectively represents forward and reverse primers -

[1] TODD E L, POOLE R W. Keys and illustrations for the armyworm moths of the noctuid genus Spodoptera Guenée from the Western Hemisphere[J]. Annals of the Entomological Society of America, 1980, 73(6): 722-738. doi: 10.1093/aesa/73.6.722

[2] 姜玉英, 刘杰, 吴秋琳, 等. 我国草地贪夜蛾冬繁区和越冬区调查[J]. 植物保护, 2021, 47(1): 212-217. [3] UZAYISENGA B, WAWERU B, KAJUGA J, et al. First record of the fall armyworm, Spodoptera frugiperda(J. E. Smith, 1797) (Lepidoptera: Noctuidae), in Rwanda[J]. African Entomology, 2018, 26(1): 244-246. doi: 10.4001/003.026.0244

[4] 王磊, 陈科伟, 钟国华, 等. 重大入侵害虫草地贪夜蛾发生危害、防控研究进展及防控策略探讨[J]. 环境昆虫学报, 2019, 41(3): 479-487. [5] 林玉英, 金涛, 金启安, 等. 椰子织蛾幼虫龄数及取食量的雌雄差异[J]. 环境昆虫学报, 2017, 39(4): 912-918. [6] 覃吕高. 家蚕抗核型多角体病毒相关蛋白及雌雄差异蛋白质组学分析[D]. 镇江: 江苏大学, 2012. [7] 王华, 方妍, 王立鹏, 等. 高温对家蚕雌雄脂肪体基因表达差异的Digital gene expression(DGE)分析[C]//中国蚕学会、国家蚕桑产业技术体系. 第十二届家(柞)蚕遗传育种暨良种繁育学术研讨会论文集(摘要汇编). 中国蚕学会、国家蚕桑产业技术体系: 中国蚕学会. 2016: 41. [8] 李爽. 雌雄意大利蝗耐高温差异及其生理生化响应对策研究[D]. 乌鲁木齐: 新疆师范大学, 2016. [9] 刘振兴. 粘虫和棉铃虫趋光行为、复眼结构及光受体基因差异研究[D]. 武汉: 华中农业大学, 2019. [10] 董前进, 周金成, 朱凯辉, 等. 一种快速鉴别草地贪夜蛾蛹及成虫雌雄的简易方法[J]. 植物保护, 2019, 45(5): 96-98. [11] 冯波, 郭前爽, 王浩杰, 等. 草地贪夜蛾的准确鉴定[J]. 应用昆虫学报, 2020, 57(4): 877-888. [12] 王世英, 朱启绽, 谭煜婷, 等. 草地贪夜蛾室内人工饲料群体饲养技术[J]. 环境昆虫学报, 2019, 41(4): 742-747. [13] 刘苏, 蒋兴川, 蒋秀云, 等. 草地贪夜蛾4个性信息素结合蛋白基因的克隆及表达模式分析[J]. 环境昆虫学报, 2020, 42(3): 583-592. doi: 10.3969/j.issn.1674-0858.2020.03.9 [14] 陆雪雷, 朱诚棋, 秦文权, 等. 凤凰木夜蛾蛹和成虫的雌雄形态鉴定[J]. 中国森林病虫, 2017, 36(4): 34-36. doi: 10.3969/j.issn.1671-0886.2017.04.009 [15] 赵晓峰, 杨安頔, 张茂新, 等. 一种快速鉴别甜菜夜蛾蛹及成虫雌雄的简易方法[J]. 环境昆虫学报, 2016, 38(5): 1066-1070. [16] 张媛媛, 沈婧, 孙朝辉, 等. 桉袋蛾蛹和成虫的雌雄形态鉴定[J]. 河北林业科技, 2016(3): 8-9. doi: 10.3969/j.issn.1002-3356.2016.03.003 [17] 牛宝龙, 翁宏飚, 孟智启, 等. 棉铃虫雌性特异性分子标记的筛选及棉铃虫幼虫的性别快速鉴定[C]//浙江省人事厅、浙江省科协、浙江省蚕桑学会. “家蚕生理、病理和生物技术”学术研讨会论文选集. 浙江省人事厅、浙江省科协、浙江省蚕桑学会: 浙江省科学技术协会. 2006: 3. [18] 王慧超, 朱勇. 家蚕雌特异分子标记筛选、克隆及其序列分析[J]. 蚕业科学, 2004(1): 34-37. doi: 10.3969/j.issn.0257-4799.2004.01.008 [19] 张利娜. 长江口降海鳗鲡雌雄判别方法及雌性特异SCAR标记的建立[D]. 上海: 上海海洋大学, 2017. [20] MASARU M, TADASHI S, YOTA T, et al. Oryzias curvinotus has DMY, a gene that is required for male development in the Medaka, O. latipes[J]. Zoolog, 2003, 20(2): 159-161. doi: 10.2108/zsj.20.159

[21] 曲彬. 中国大鲵性别特异性DNA标记的鉴定及雌雄性腺差异表达基因的分析[D]. 杨凌: 西北农林科技大学, 2015. [22] 田媛. 双须骨舌鱼雌雄鉴别与性腺发育研究[D]. 上海: 上海海洋大学, 2013. [23] 田志强, 孙丽娜, 李艳艳, 等. 昆虫性信息素结合蛋白功能研究进展[J]. 农学学报, 2017, 7(9): 14-20. doi: 10.11923/j.issn.2095-4050.cjas16110038 [24] 牛小慧. 甜菜夜蛾信息素结合蛋白的表达动态及其受交配和钟基因沉默的影响[D]. 南京: 南京农业大学, 2011. -

期刊类型引用(3)

1. 刘振国, 孙永旺, 张喜珍, 刘宜浩, 鲍荣中. 基于改进DeepLabV3+网络的荔枝种植面积提取方法. 农业工程学报. 2025(12)  百度学术

百度学术

2. 王德传. 利用U-Net神经网络的多光谱图像草地特征提取. 地理空间信息. 2024(08): 41-44 .  百度学术

百度学术

3. 周易. 基于Densenet-SVM的遥感图像场景分类网络研究. 数字通信世界. 2023(11): 29-32 .  百度学术

百度学术

其他类型引用(7)

下载:

下载: