Study on the extraction method of sugar tangerine fruit trees based on UAV remote sensing images

-

摘要:目的

通过无人机获取沙糖橘果园的遥感图像,快速提取果树分布位置,为果树的长势监测和产量预估提供参考。

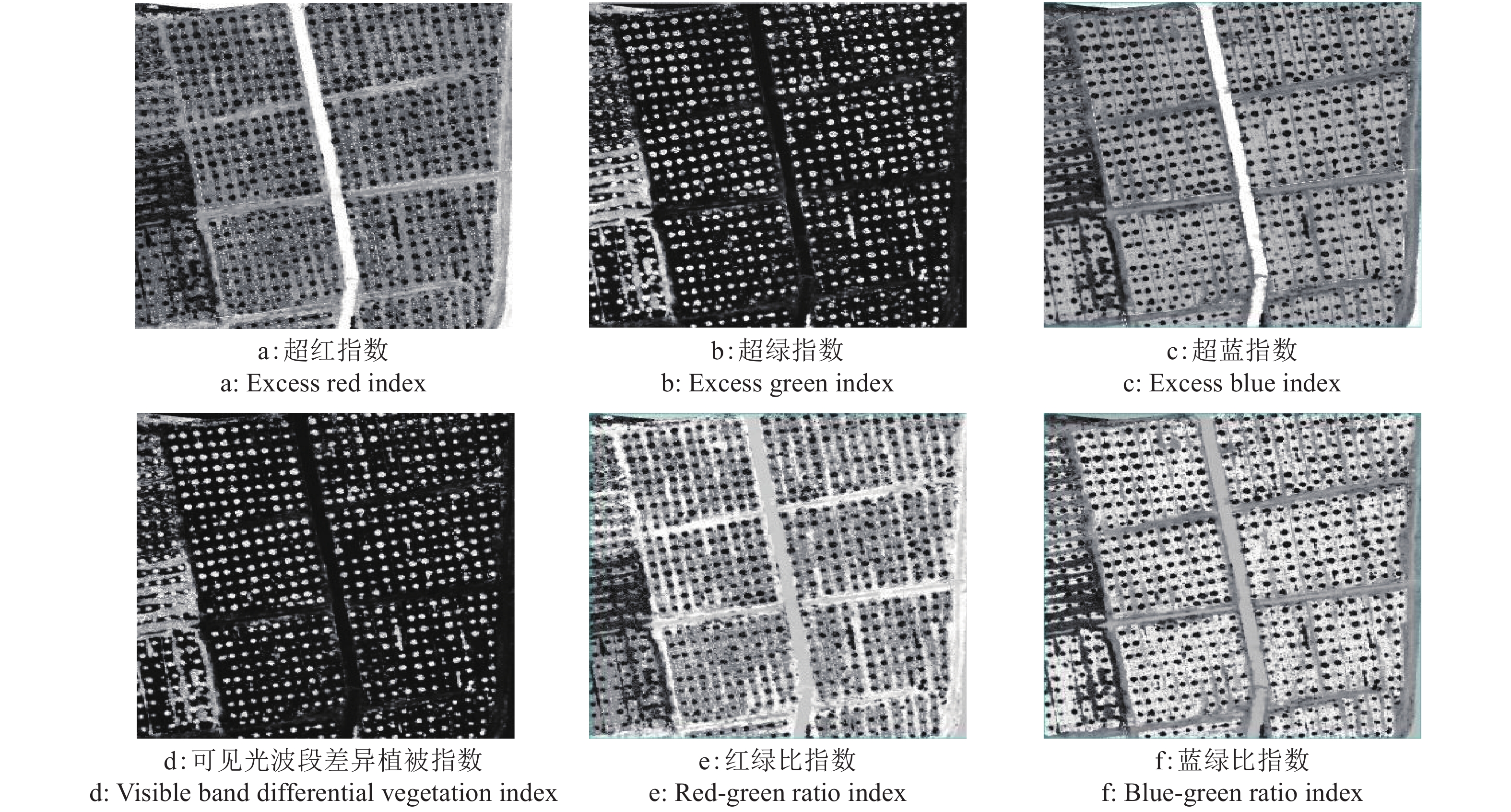

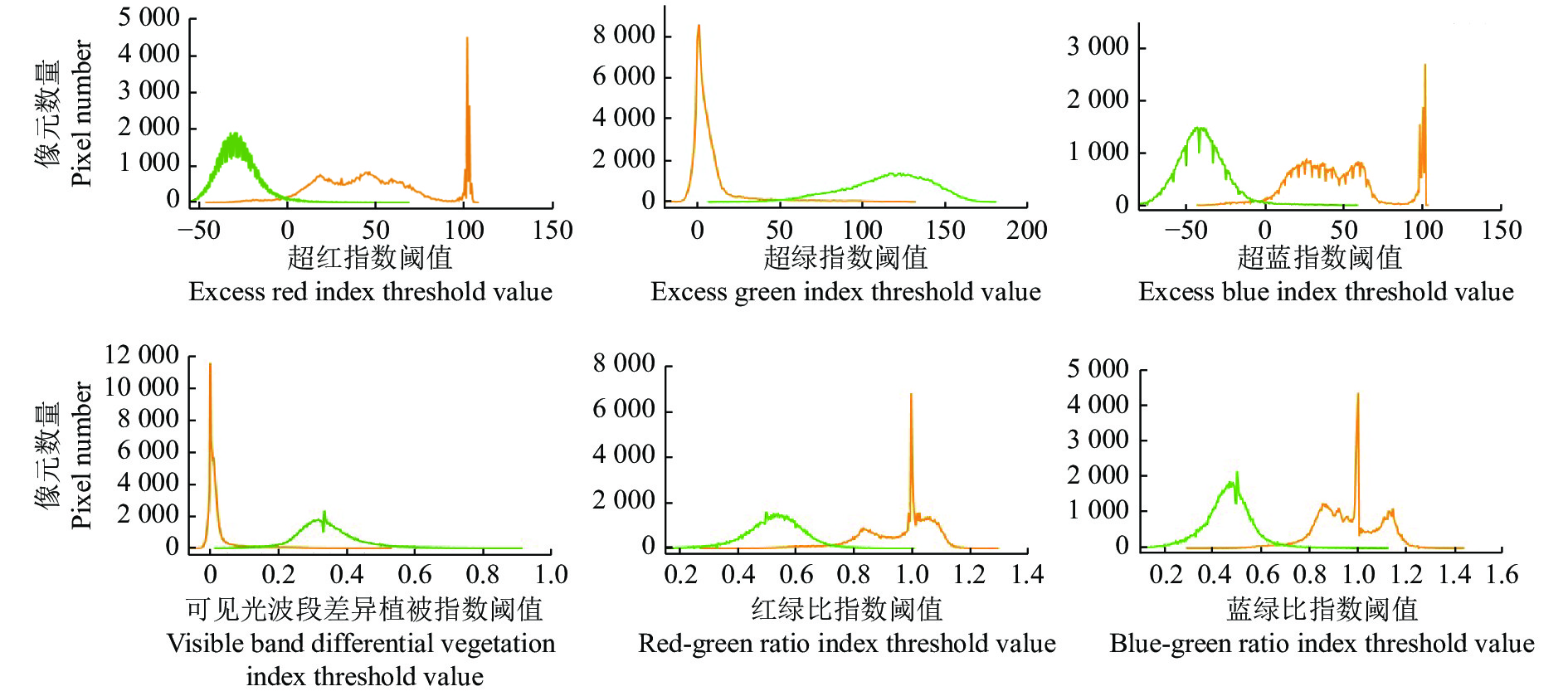

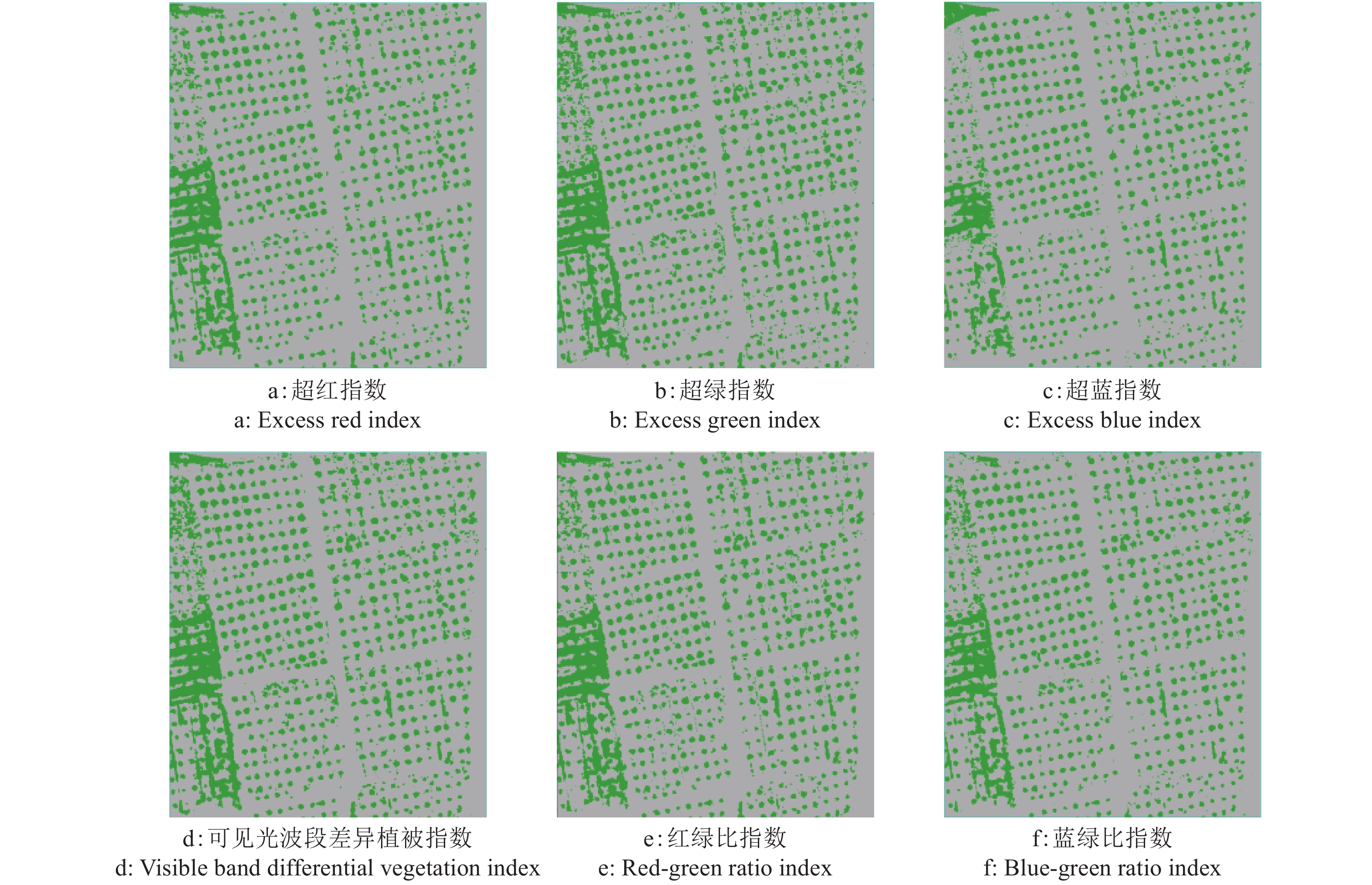

方法以无人机拍摄的可见光遥感图像为研究对象,计算超红指数、超绿指数、超蓝指数、可见光波段差异植被指数、红绿比指数和蓝绿比指数6种可见光植被指数,使用双峰阈值法选取阈值进行果树的提取。在使用光谱指数进行识别的基础上,结合数字表面模型作为识别模型的输入变量,进行对比试验。

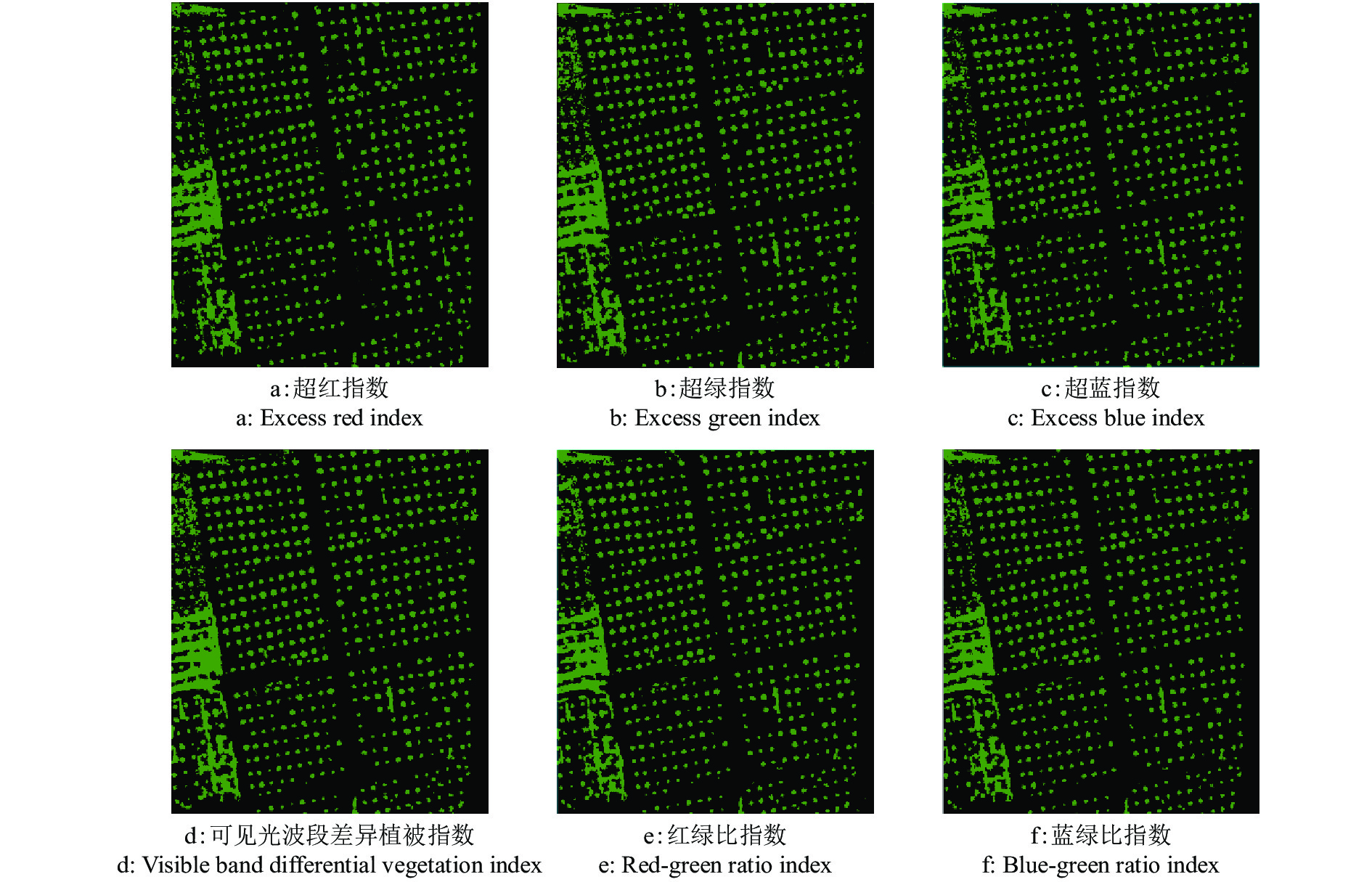

结果相比使用单一光谱指数,结合数字表面模型提高了果树和非果树像元的提取精度,6次波段融合后的总体精度均大于97%。超红指数与数字表面模型结合后的总体精度最高,为98.77%,Kappa系数为0.956 7,植被信息提取精度优于其他5种可见光植被指数与数字表面模型结合后的提取精度。

结论数字表面模型结合可见光植被指数的提取方法能够更深层次地挖掘遥感数据蕴含的信息量,为影像中色调相似地物的提取提供参考。

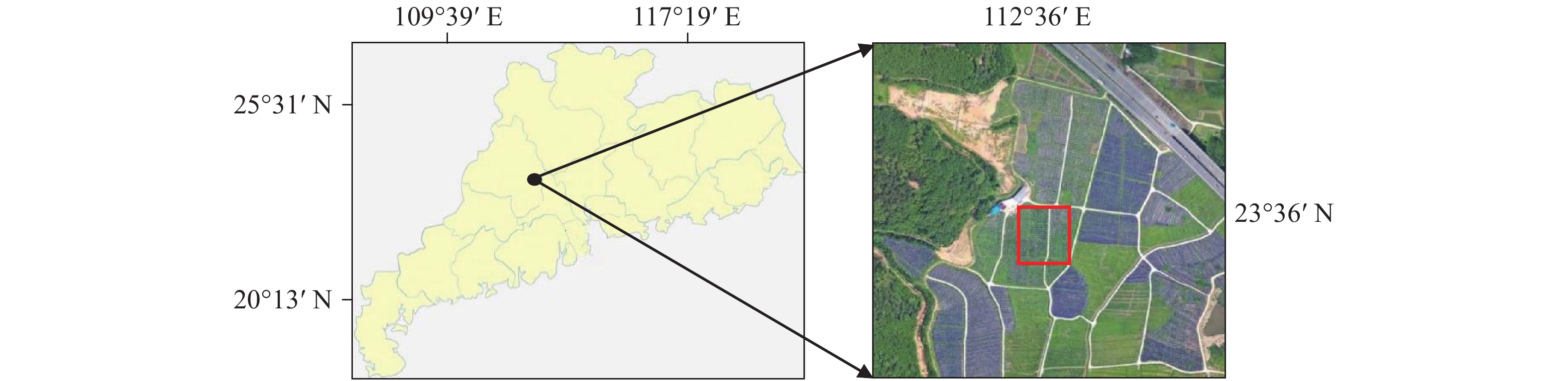

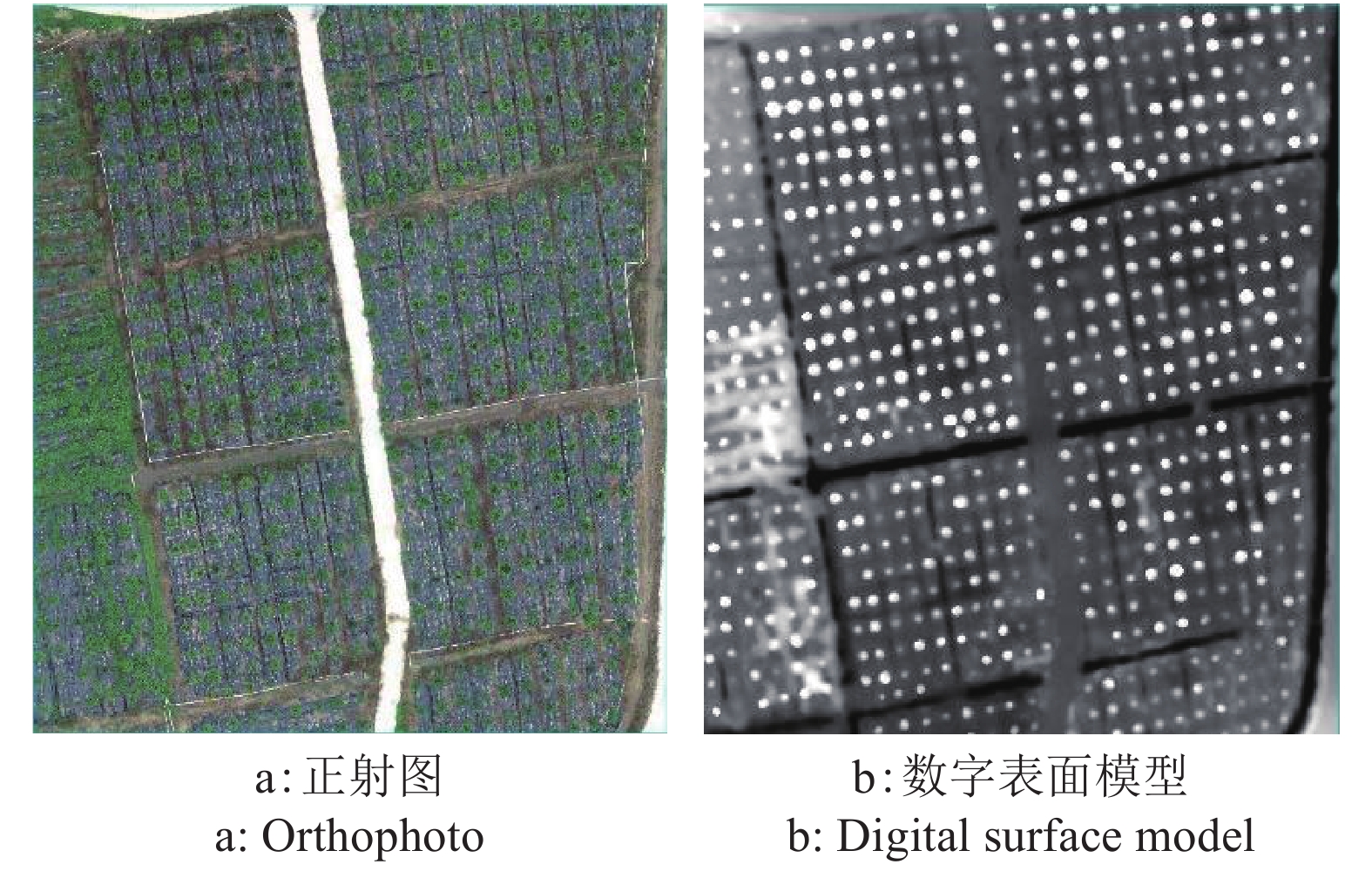

Abstract:ObjectiveTo obtain remote sensing image of sand sugar tangerine orchard by UAV, rapidly extract the distribution position of fruit trees, and provide references for growth monitoring and yield prediction of fruit trees.

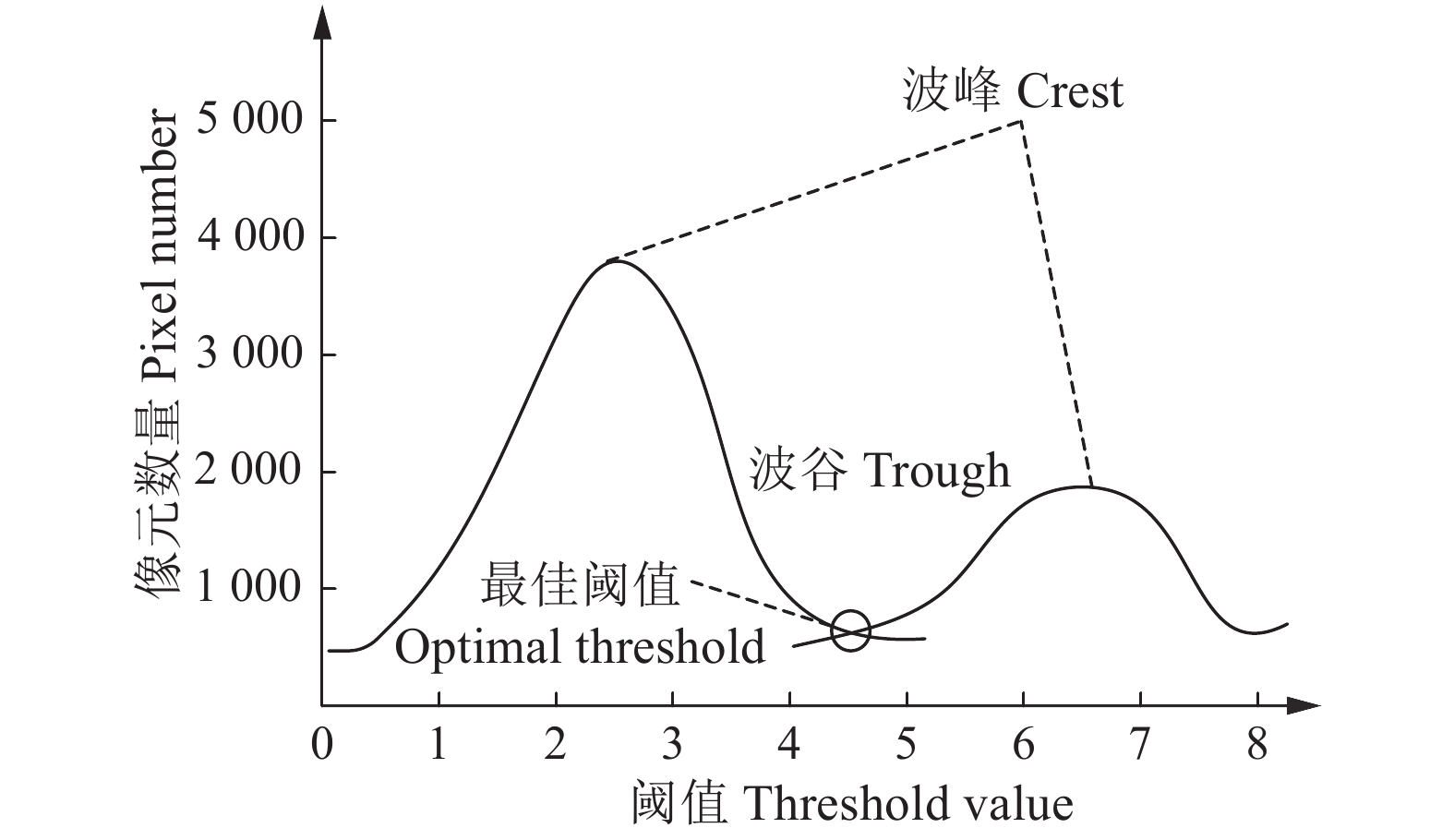

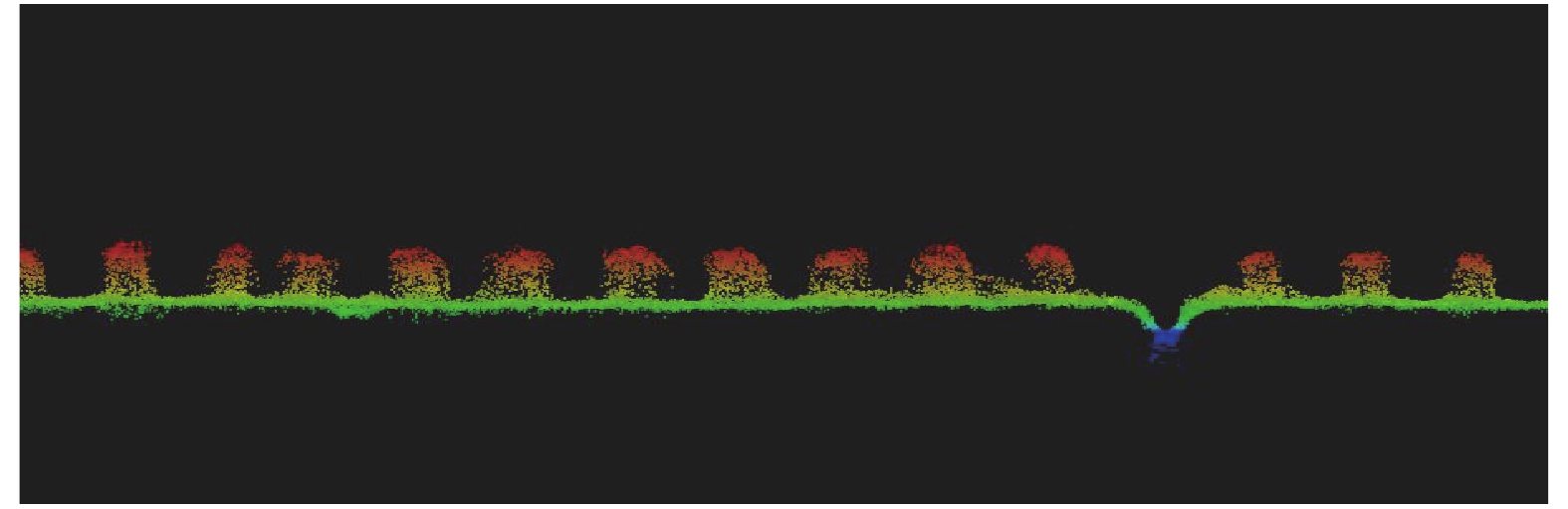

MethodThe visible light remote sensing images taken by drones were used as the research object. Six visible light vegetation indexes of excess red index, excess green index, excess blue index, visible band differential vegetation index, red-green ratio index and blue-green ratio index were calculated. We used the double peak threshold method to select the threshold for fruit tree extraction. Based on the spectral index identification, digital surface model was added as input variable of the identification model, and the comparative test was conducted.

ResultCompared with using a single spectral index, the addition of digital surface model improved the extraction accuracies of fruit tree and non fruit tree pixels. The total accuracies of six band fusions were all greater than 97%. The total accuracy of excess red index combined with digital surface model was the highest (98.77%) with Kappa coefficient of 0.956 7, and the vegetation extraction accuracies were superior to those of other five combinations of visible light vegetation indexes with digital surface model.

ConclusionThe combination of digital surface model with visible light vegetation index can excavate more deeply the information contained in the remote sensing data, and provide a reference for the extraction of similar tonal features in the image.

-

化学除草是目前最有效且广泛采用的水稻田杂草管控方式[1],常用的方法是对整个作业区域均匀和覆盖式的喷洒除草[2],以无序的“点状”或“片状”形式存在的杂草会导致农药喷洒过量。“精准农业航空”中基于遥感分析的精准施药为解决农药过量施用问题提供了一种新思路[3-4]。精准施药的首要任务是获取水稻田的遥感图像并分析其中的杂草分布状况,得到网格形状的杂草分布图。水稻田图像中水稻及杂草颜色相近,若依据图像识别其差异,则要求遥感图像具有较高的空间分辨率。近年来无人机低空遥感因操作简单、节省人力物力并可获得高分辨率影像的优势为农作物分类调查提供了新思路[5],相比传统卫星影像,具有获取方式更灵活、时效高等特点,在农情监测、精准农业等领域得到越来越多的应用[6-7]。利用无人机采集水稻田的遥感图像并进行农情分析在国内外已有类似的研究。Barrero等[8]使用神经网络(Neural network)对水稻杂草航空图像进行检测,检测准确率高达99%;Barrero等[9]根据无人机拍摄的图像提出一种融合低分辨率多光谱和高分辨率RGB图像的方法检测水稻田杂草,采用神经网络对RGB、RGB+NGRDI和融合RGB-NGRDI 共3种图像进行检测,结果表明基于融合图像的杂草检测精度最高,在70%~85%之间;Uto等[10]使用无人机获取水稻的高光谱数据,通过频繁地监测照明水平和叶绿素指数获得水稻田的生长信息;马明洋[11]使用无人机获取稻田中水稻冠层高光谱影像信息,对光谱特征信息进行分类,其中使用二代小波分解算法分类精度最高,达到90.36%;洪雪[12]利用无人机获得农田中水稻的光谱数据,使用BP神经网络建模对水稻产量进行预测;Ma等[13]使用SegNet、FCN和U-Net 共3种语义分割模型对水稻田中的水稻杂草图像进行像素级的分割,结果表明,SegNet算法识别效果最好,达到92.7%的准确率。相关研究主要集中在对水稻田杂草的识别检测上,获取水稻田中杂草分布信息并生成水稻田间杂草分布图的研究相对较少。本文拟采用大疆精灵4无人机及其携带的可见光相机采集遥感图像,以水稻杂草为识别目标,对比支持向量机(Support vehicle machine, SVM)、K最近邻算法(K-nearest neighbor, KNN)、AdaBoost共3种机器学习方法和卷积神经网络(Convolutional neural network,CNN)方法对水稻和杂草的分类效果,获取水稻田间杂草分布信息,生成分类效果最好的水稻田间杂草分布图,为后续植保无人机进行精准施药提供决策依据。

1. 材料与方法

1.1 供试材料

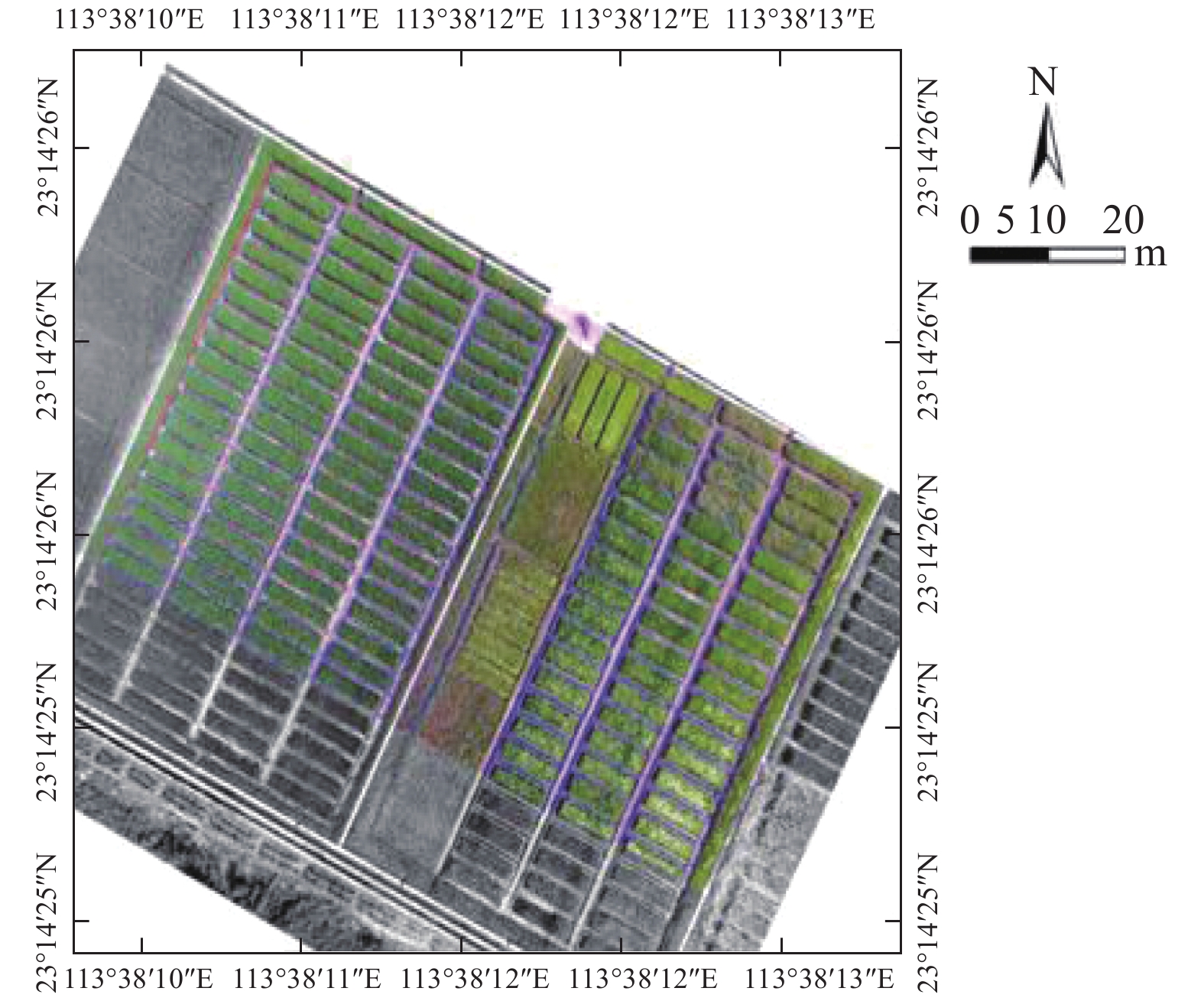

研究区域位于华南农业大学增城试验基地(中国广东省广州市,坐标23°14′N、113°38′E,基准WGS84)(图1)。本研究于2017年10月2日对试验基地中某一块稻田进行RGB图像采集,数据采集设备为大疆精灵4无人机,结合地面站软件DJI GS PRO进行航线规划。经实地验证,研究区域的杂草主要有千金子和莎草。

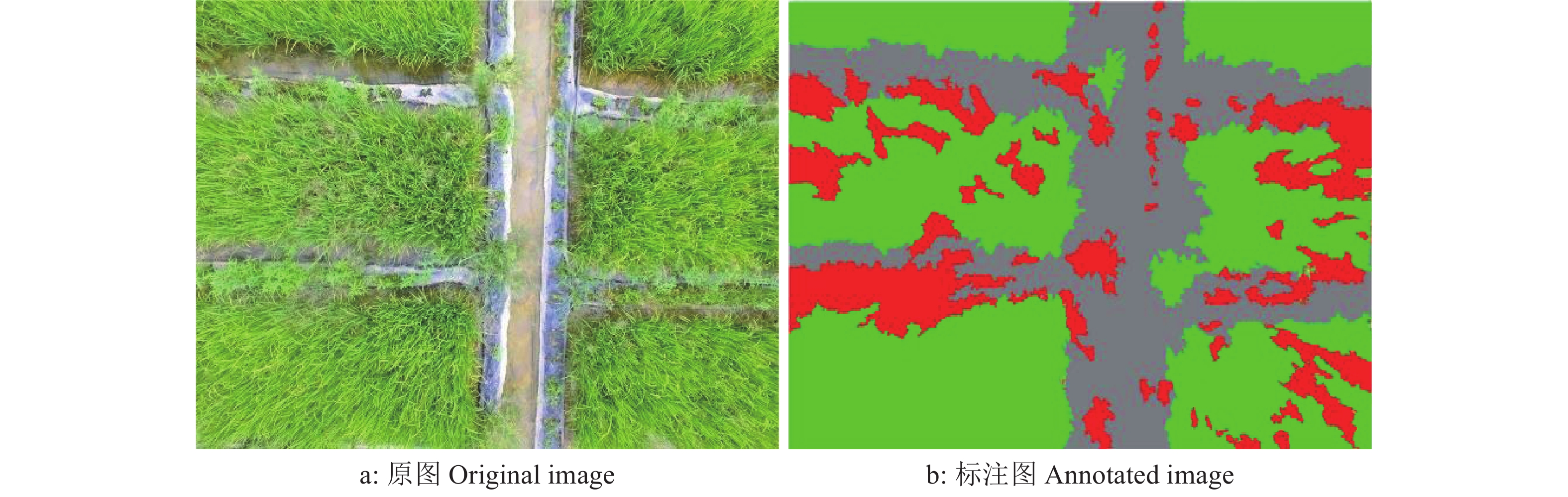

无人机飞行高度依次设置为6、8、10 m。横、纵向重叠率分别为60%和50%。本次试验采集图像120幅,每幅图像的分辨率为4 000像素×3 000像素,空间分辨率为0.3 cm。采集到的图像如图2a所示。根据人眼对水稻和杂草的识别效果以及需要对采集的图像使用有监督学习作用的方法进行标注,试验选择飞行高度为6 m。在采集到的无人机遥感图像中,所有物体被分为3个类别:水稻、杂草以及其他(包括水泥地、土壤、地面等)。本文分别使用绿色表示水稻,红色表示杂草,灰色代表其他,对每一张图像中3个类别进行基于像素级别的颜色标注,如图2b所示。

根据田间地面的实际验证,在1个0.3 m×0.3 m的网格中有95%以上概率可确认只有1个类别。考虑有限的计算机资源以及图像的分辨率即像素尺寸为4 000×3 000,空间分辨率为0.3 cm,根据计算,0.3 m×0.3 m的地面区域对应图像的像素尺寸为100×100,因此本文将每幅4 000像素×3 000像素的原图像与标记图像分别切割成1 200块像素大小为100×100的小网格。对原图像切割成的小网格图片与标记图切割成的小网格图片进行效果比对,在标记图小网格图库中,按照单一颜色或者某种颜色超过95%的选取规则与原图像库中的小图片进行对应,按照随机性以及训练集与测试集5∶1的原则选出6 000幅小网格图片作为训练集,选取1 200幅小网格图片作为测试集。

1.2 数据预处理

1.2.1 基于机器学习分类的图像预处理

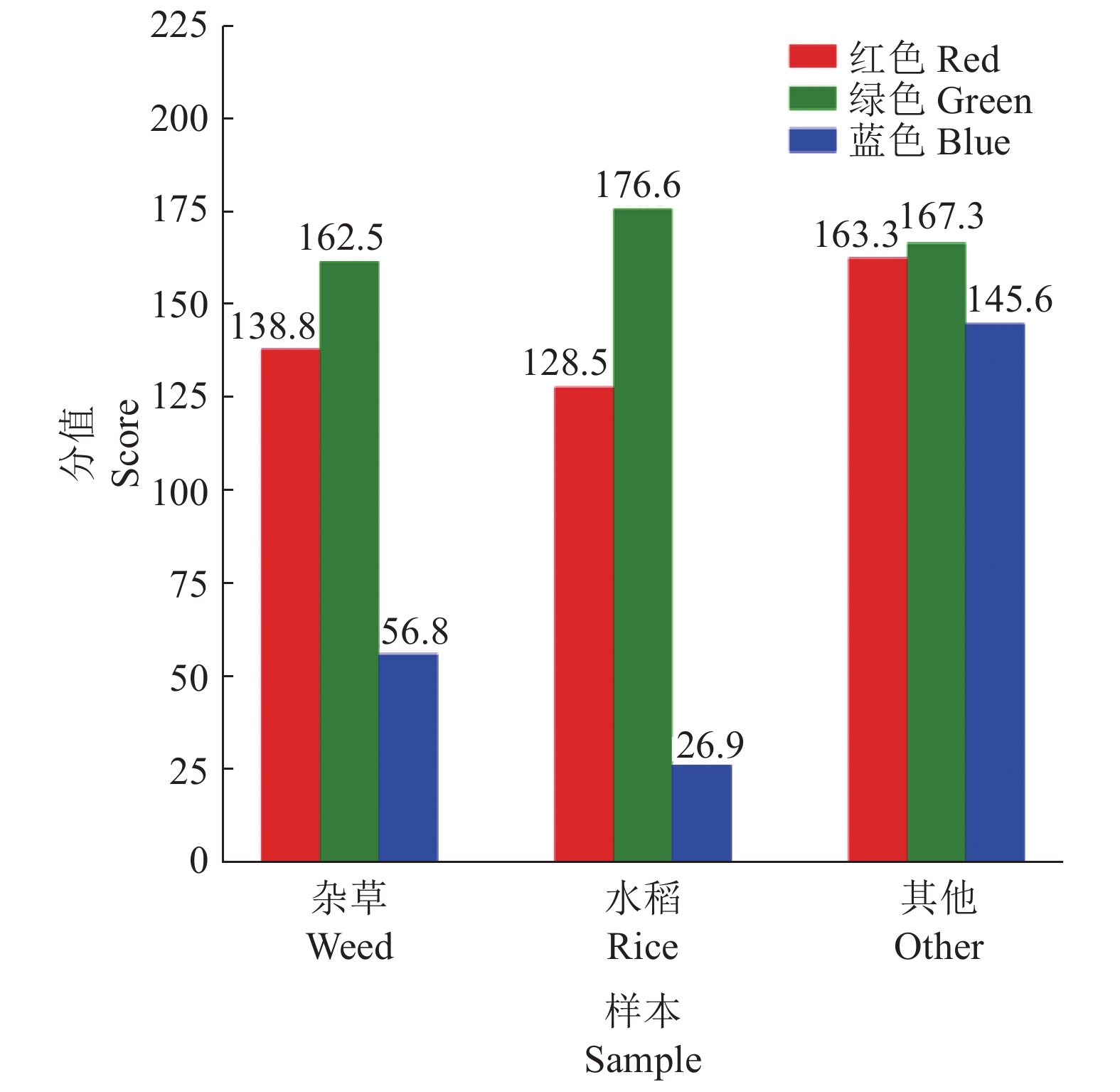

颜色特征是基于图像像素提取的,具有旋转、尺度和平移不变性等优点[14],是人眼获取的最为有效且明显的信息之一。它的获取及计算较简单,常用作特征向量训练机器学习模型。本试验拟对小样本提取RGB三通道颜色的最大值、最小值与平均值。从原图小网格图库中随机选取3种类别小图片各3 200幅用于统计RGB像素平均值(图3),不同类别样本提取出的颜色特征有一些差异。

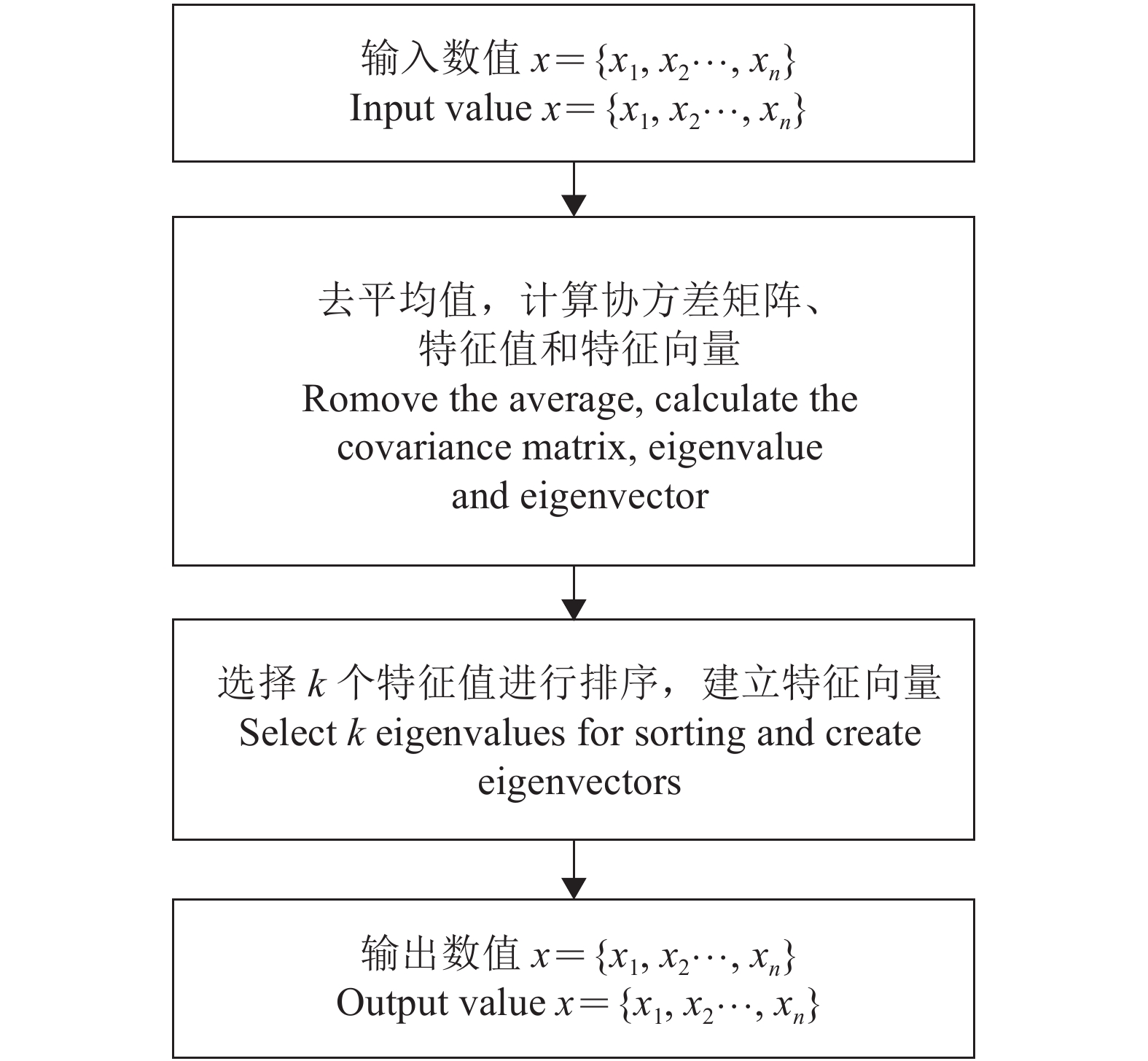

本文的图像属于单视图数据,数据维数巨大。尽管高维数据含有更加丰富的信息,但对于分类、聚类等任务,要付出巨大的计算和存储代价,而且在测试集数量一定时,特征维数的增加将使样本统计特性变得困难,降低分类器的泛化能力[15]。本文使用对单视图数据有较好泛化性能的主成分分析(Principal component analysis,PCA)对图像数据进行降维。PCA是Karl Pearson[16]在1901年提出的概念,1933年Hotelling[17]完善其数学基础。本研究原始图像的特征向量有30 000维存在噪声和冗余信息,会对分类器造成干扰,因此采用PCA降维来消除这种影响[18]。经过如图4所示的PCA计算流程,为保留90%有效信息并降到50维,剔除无效的信息,保留有用的特征信息,形成特征向量集。结合提取到的颜色特征分别送入SVM、KNN和AdaBoost 3种分类器中进行识别分类。

1.2.2 基于CNN分类的图像预处理

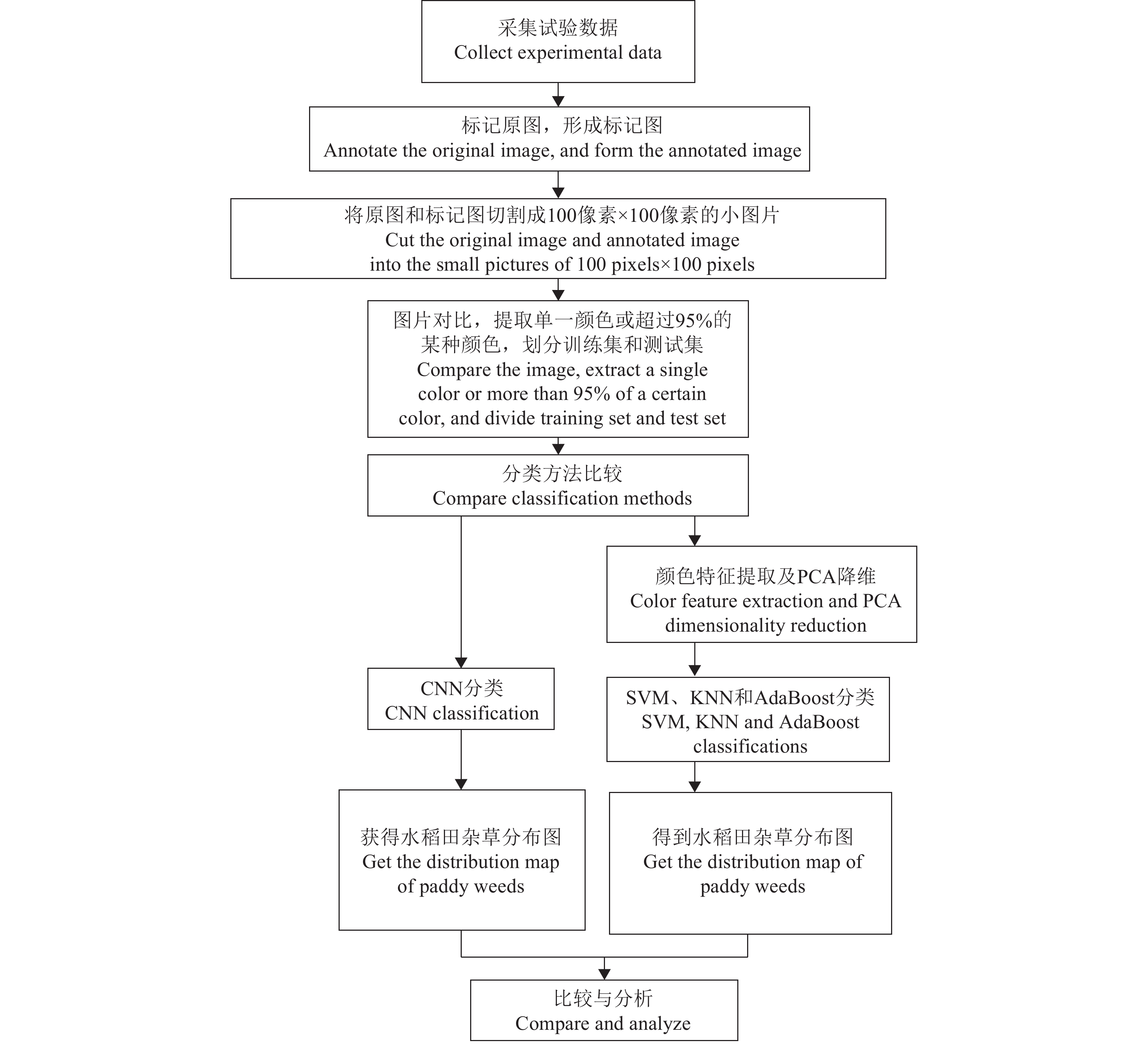

CNN可以自动学习输入图像中的特征,并对学习到的特征进行自动分类,网络直接输出该图像的类别概率,是一种端到端的图像识别方法[19]。CNN通过卷积运算完成特征提取。图像卷积运算是通过设定各种特征提取滤波器矩阵,然后使用该卷积核在原图像矩阵(图像实际是像素值构成的矩阵)“滑动”,实现卷积运算。因此,基于CNN对图像的分类无需做预处理,可直接进行模型的训练。本文的技术路线如图5所示。对原始图像进行标注、切割后使用3种机器学习算法和CNN对小图片进行分类,并形成水稻田中的杂草分布图。

1.3 分类方法介绍

常用的监督分类方法有最大似然[20]、神经网络[21-22]、SVM[23-24],常用的非监督分类方法有K−均值、模糊C−均值(Fuzzy C-mean,FCM)[25-26]等。获取的图像数据经标注后使得本文的分类方法成为监督分类范畴。

1.3.1 SVM分类模型

SVM是一种可分析数据、识别模型和分类的监督学习模型[27-28]。SVM算法在于寻找一个超平面,该超平面可将训练集中的数据分开,且与类域边界边沿垂直于该超平面方向的距离最大,从而达到最大的泛化能力[29]。对于任意数据集

$\mathbb T $ 和超平面${\boldsymbol{\omega}} {{x + {\boldsymbol{b}} = 0}}$ ,定义超平面关于样本点$({{{x}}_{{i}}},\ {{{y}}_{{i}}})$ 的几何间距(ri)为:$${\gamma _{{i}}}{\rm{ = }}{{{y}}_{{i}}}\Bigg(\frac{{\boldsymbol{\omega}} }{{\parallel {\boldsymbol{\omega}} \parallel }} x_i{\rm{ + }}\frac{{\boldsymbol{b}}}{{\parallel {\boldsymbol{\omega}} \parallel }}\Bigg),$$ (1) 式中,

${\boldsymbol{\omega}}$ 、b分别是超平面的权重向量与截距向量。关于全部样本点的几何间隔的最小值$(\gamma) $ 为:$$\gamma {\rm{ = min}}{\gamma _i}(i = 1,2\cdots ,n),$$ (2) 即向量到超平面的距离。

以上都是针对数据线性可分推导的,本文的图像数据属于线性不可分,必须确定惩罚系数c和径向基函数g,再选择更优的核函数将数据映射到更高维空间,有效解决数据低维和高维空间映射造成计算复杂度增加的问题[30]。常用的核函数有线性核、多项式核、径向基内核和Sigmoid核。选择核函数时要考虑数据的特点和数据量,本次SVM模型使用的是Sigmoid核,通过使用不同的核函数和参数c、g寻优,Sigmoid核的公式如下所示:

$$K(x,y) = \tanh (\mathop {{{a}}x}\nolimits^{\rm T} y + b),$$ (3) 式中,a、b为人工设置的参数,a为正实数,b为非负实数。

1.3.2 KNN分类模型

KNN是机器学习领域最常用的分类算法,也是一种回归的非参数统计方法[31]。优点是可用于非线性分类,适用于本文的遥感数据且对异常数据不敏感,缺点是需要大量的存储空间,计算耗时。分类的思路是假设一个样本在特征空间中的k个最近邻的样本大多数属于某个类别,则将该样本也划分成这个类别。本文使用KNN算法建模时,关于距离的度量方法使用的是欧几里得距离公式,具体如下:

$$D = \sqrt {\sum\limits_{i = 1}^n {{{({x_i} - {y_i})}^2}} } ,$$ (4) 式中,

${x_i}$ 代表待测样本,${y_i}$ 代表已知样本,n代表样本数。1.3.3 AdaBoost分类模型

本文选取AdaBoost算法构建小尺度的水稻田杂草图像分类模型。AdaBoost算法是由Freund等[32]提出的目前使用和研究最多的集成算法,该算法的思想是将若干个分类能力较弱的分类器按照一定的方式混合成为分类能力很强的强分类器[33-34]。AdaBoost算法计算流程如下:

1)构造图像特征数据训练集为G={

$({x_1}, {y_2}), ({x_2},{y_2})\cdots,({x_n},{y_n})$ },xn为图像的特征数据集,yn为标签集。2)初始化每个图像特征数据的权值D1={

${w_1},{w_2}\cdots,{w_n}$ },${w_n}$ =1/n,${w_n}$ 为第n个图像特征数据对应的初始权值。3)迭代k次(k=1, 2···, K),使用决策树算法对有权值分布的训练集训练出弱分类器。

1.3.4 CNN分类模型

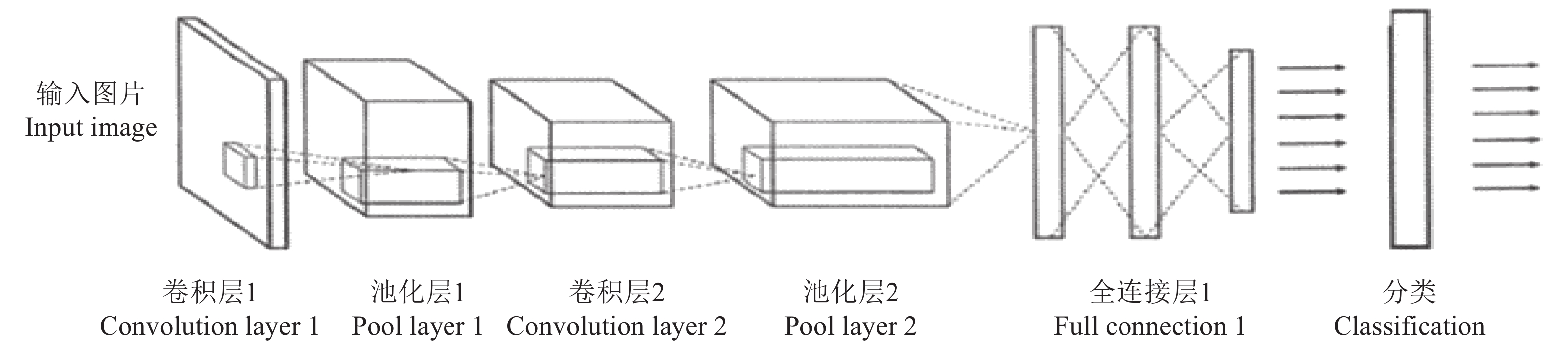

作为一种深度学习方法,CNN已成为当前图像理解领域的研究热点[35],其权值共享网络结构在网络输入为多维图像时尤为方便,图像可直接作为网络输入,避免传统识别算法中复杂的特征提取和数据重建过程[36]。本文采用CNN对采集到的水稻田杂草图像进行分类,CNN结构的隐含层一般包含卷积层、采样层、池化层和全连接层等几类常见的层结构,本文使用的卷积层结构如图6所示。

卷积层中的卷积核包含权重系数,用来自动提取图像的特征。本文所使用的CNN结构是在Ubuntu16.04系统下,框架为tensorflow 1.5,编程语言为Python,训练集与测试集的图片分别为6 000与1 200幅。考虑到有限的计算机资源,卷积层只设置5个卷积核,每个卷积核大小为1,利用ReLU函数进行激活。池化层池化窗口大小为5×5,步长为2×2。将提取到的三维特征转化成一维向量,全连接层对提取到的特征进行分类。学习率设置为10−5,最后选用AdamOptimizer优化网络。

2. 结果与分析

2.1 算法的分类结果与分析

对相同的数据集经过颜色特征的提取和PCA降维后,将形成的特征向量集分别送入到SVM、KNN以及AdaBoost分类器中进行分类。对分类器的参数进行多次的调优试验。

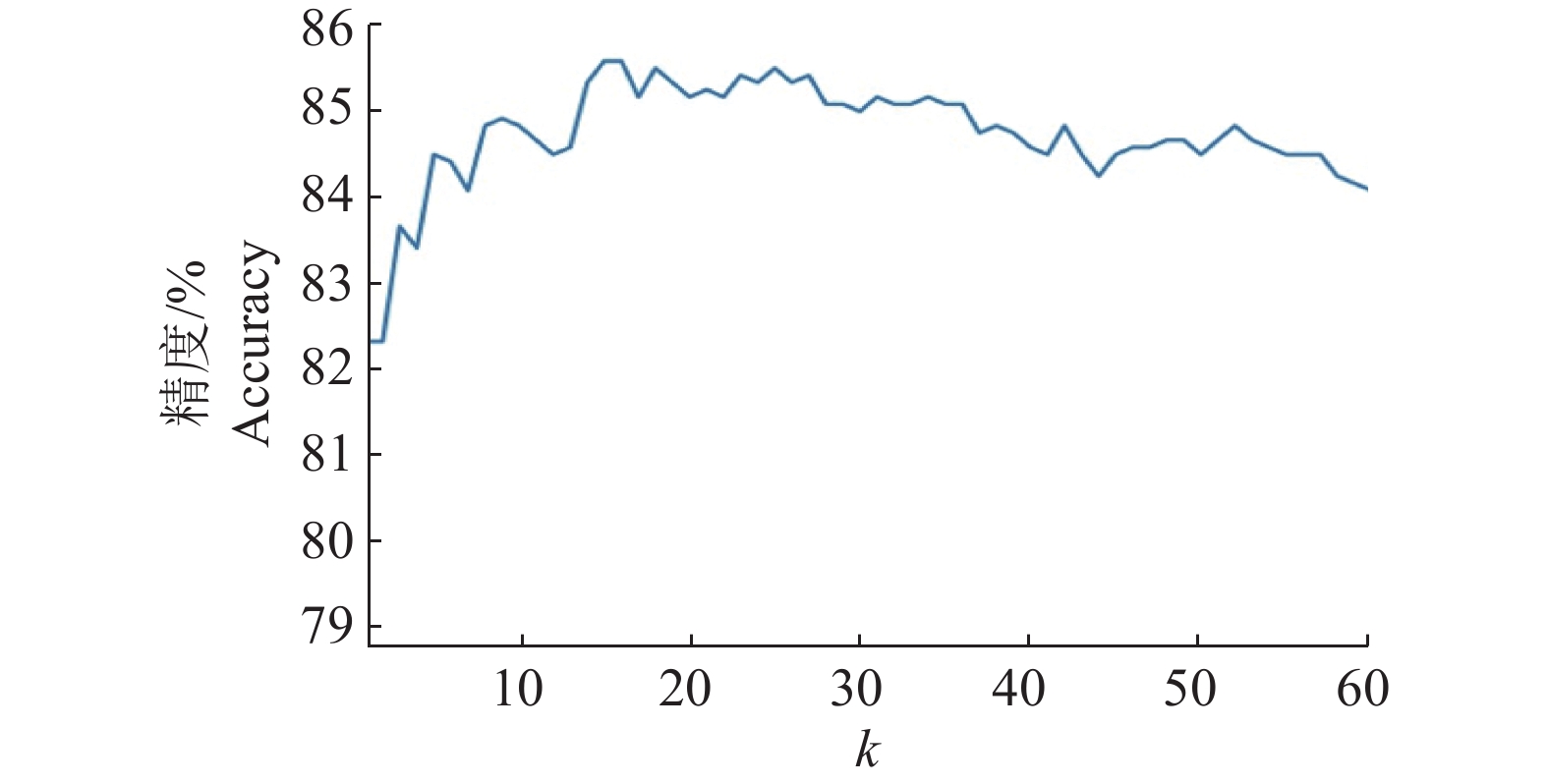

试验结果表明,SVM算法对3种作物类别(水稻、杂草、其他)的综合分类精度为89.75%。图7展示的是KNN算法分类精度与k值的关系,当k取14时,KNN综合识别精度最高,为85.58%。AdaBoost分类器对水稻杂草图像的综合分类精度为90.25%,为3种机器学习算法中最高。3种模型的综合识别精度、混淆矩阵精度和运行时间如表1所示。

表 1 3个模型的混淆矩阵精度、运行时间和综合识别精度Table 1. Confusion matrix accuracy, run time and integrated recognition accuracy of three models模型

Model项目

Item精度/% Accuracy 运行时间/s

Run time综合识别精度/%

Integrated recognition accuracy真实为杂草

True weed真实为水稻

True rice真实为其他

True other objectSVM 预测为杂草 Predicted weed 78.04 10.98 10.98 0.500 4 89.75 预测为水稻 Predicted rice 7.07 92.60 0.32 预测为其他

Predicted other object2.40 0.90 96.69 KNN 预测为杂草 Predicted weed 87.80 4.47 0.07 2.209 2 85.58 预测为水稻 Predicted rice 16.88 82.32 0.80 预测为其他

Predicted other object9.94 0 90.06 AdaBoost 预测为杂草 Predicted weed 82.93 11.29 5.28 0.411 1 90.25 预测为水稻 Predicted rice 6.91 92.77 0.32 预测为其他

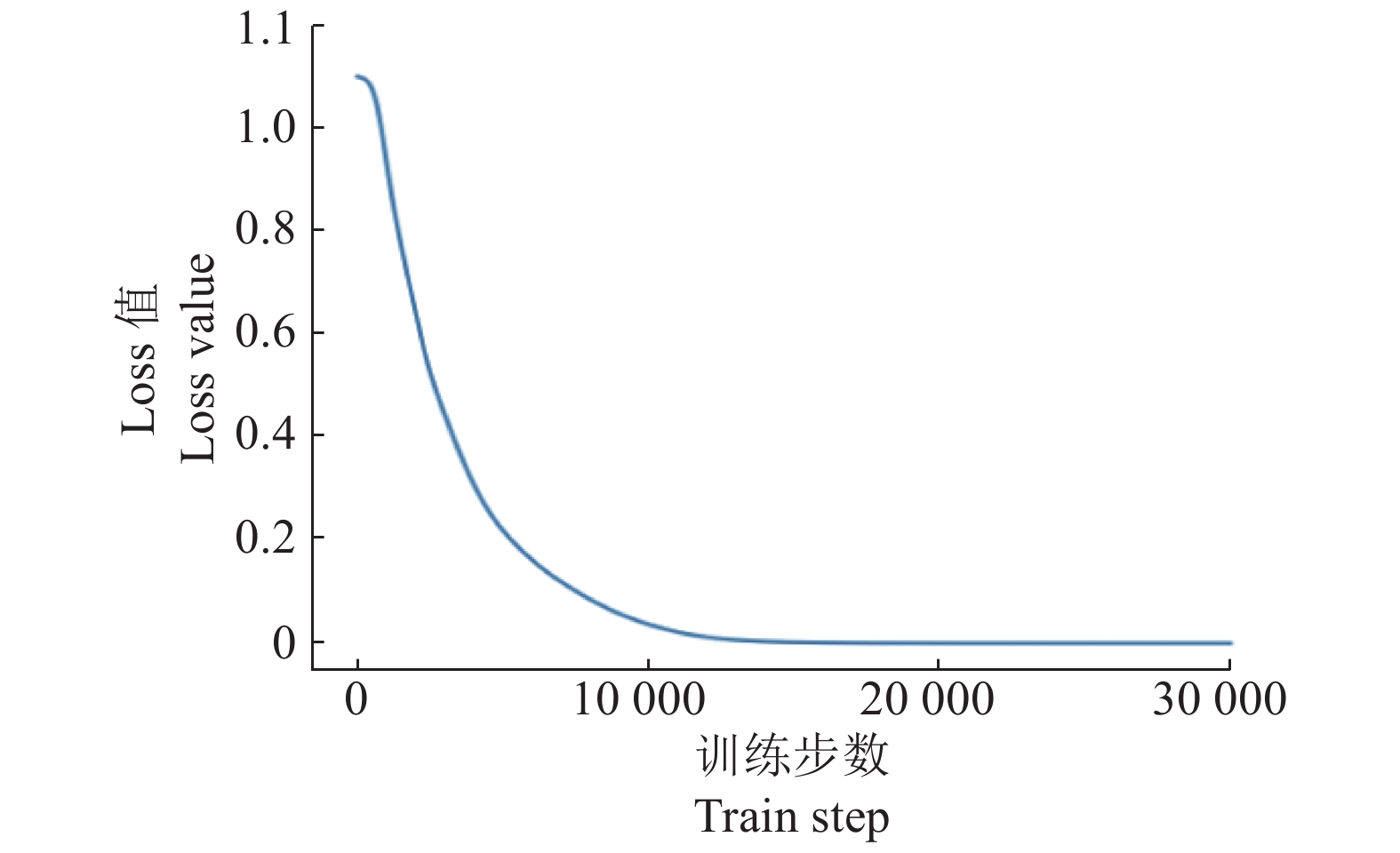

Predicted other object7.23 1.81 90.96 SVM、KNN和AdaBoost模型对测试集的测试运行时间分别为0.500 4、2.209 2和0.411 1 s。AdaBoost在分类精度和识别效率上都优于其他2种模型。基于CNN试验的模型是深度学习框架TensorFlow的GitHub代码库下的源码,通过对卷积层、池化层以及全连接层做了一些修改(图6)以适应本试验的数据,模型对整个数据集的综合分类精度是92.41%。图8是CNN训练的Loss值与训练步数的关系图。

2.2 生成水稻田间杂草分布图

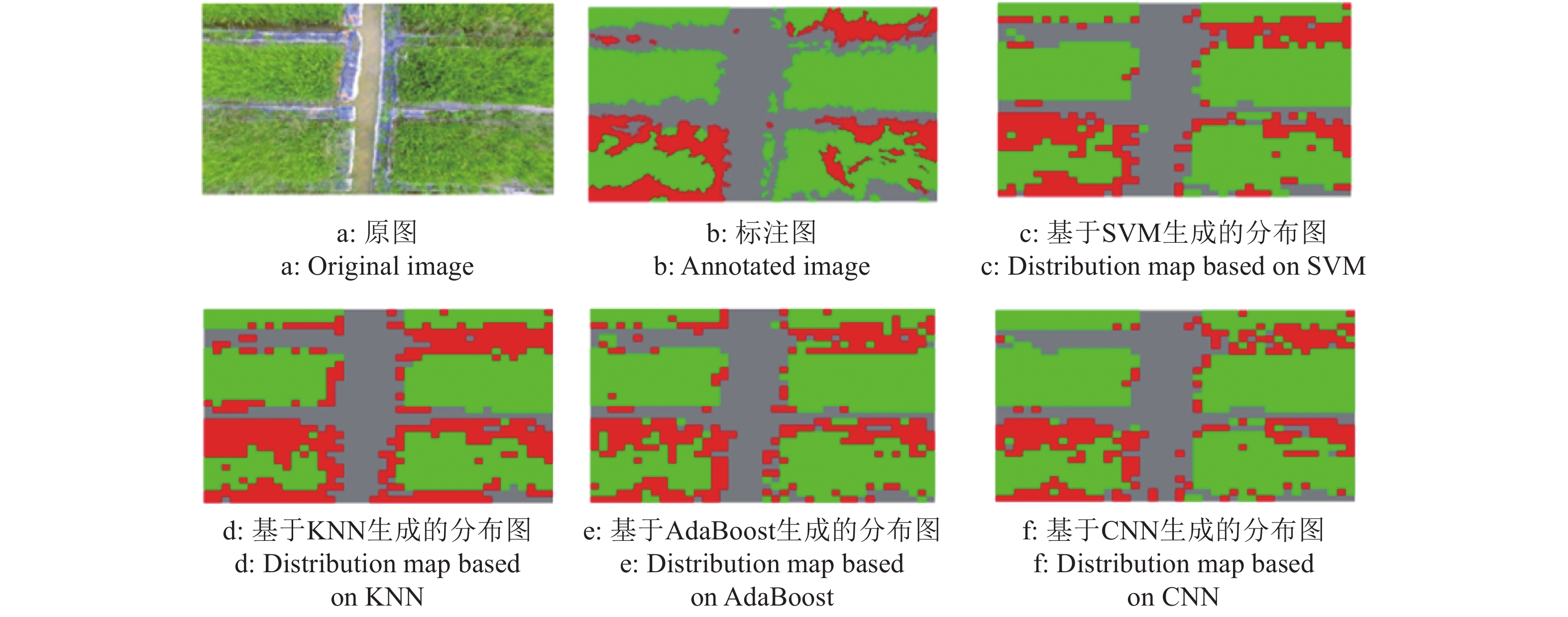

分别使用这4种训练生成的模型对测试集小样本进行分类,将小样本分类识别结果返回到相应的原始图像中进行标记,4种模型下水稻田杂草分布图与原图、标注图的比较如图9所示。

由以上的试验结果效果图以及得到的分类精度可以得到,基于CNN对水稻杂草的分类效果要优于传统机器学习算法对水稻杂草的分类效果。机器学习算法及CNN均能够有效获取水稻田中杂草分布信息并生成水稻田间杂草分布图,有利于植保无人机对稻田中的杂草进行精准施药。

3. 讨论与结论

本文使用无人机采集水稻杂草RGB可见光图像,将数据切割成像素尺寸为100×100的小网格图像,对数据集进行颜色特征提取和降维后送入SVM、KNN和AdaBoost三种机器学习算法模型中进行分类。对比试验了3种机器学习方法和1种无需提取图像特征和降维的CNN分类方法。从分类的试验结果看,在3种机器学习算法中,不论是分类准确率还是分类效率,最优的分类器是AdaBoost,其综合识别精度为90.25%;在基于CNN的分类中,由于CNN结构可以自动挖掘数据的特征,简化人工提取环节,更具有兼容性和适用性,对不同的水稻杂草图像泛化能力更好,对水稻杂草图像的综合识别精度可以达到92.41%。试验结果还表明,针对无人机拍摄的遥感图像,机器学习算法及CNN能够有效识别出水稻和杂草,获取杂草的分布信息,生成水稻田间的杂草分布图,为后续植保无人机的精准施药提供依据。结合本文的研究和所得结果分析,本研究还存在以下待改进之处:1)本文使用的机器学习算法只提取图像的颜色特征作为模型训练的特征向量集进行训练,可以在后续研究中提取多个图像特征如纹理、形状等特征进行特征融合,结合机器学习算法并在此基础上改善算法模型,形成新算法以改善分类准确率;2)后续考虑采集多时期、多田地的水稻杂草图像,基于这些不同的水稻杂草图像改善模型,提高模型泛化能力;3)本文是进行水稻杂草的图像分类,切割成100像素×100像素小网格后,个别网格中避免不了水稻和杂草共存的情况,下一步可以考虑基于像素级别的分类,提高分类的精度。

-

表 1 可见光植被指数

Table 1 Vegetation indexes based on visible spectrum

植被指数 Vegetation index 表达式1) Equation 理论区间 Theory interval 超红指数 Excess red index $1.4R - G$ [−255, 357] 超绿指数 Excess green index $2G - R - B$ [−255, 510] 超蓝指数 Excess blue index $1.4B - G$ [−255, 357] 可见光波段差异植被指数 Visible band differential vegetation index $\dfrac{ {2G - R - B} }{ {2G + R + B} }$ [−1, 1] 红绿比指数 Red-green ratio index $\dfrac{R}{G}$ [−1, 1] 蓝绿比指数 Blue-green ratio index $\dfrac{B}{G}$ [−1, 1] 1) R:红光波段,G:绿光波段,B:蓝光波段

1) R: Red light wave band, G: Green light wave band, B: Blue light wave band表 2 基于感兴趣区域的6种可见光植被指数的统计值

Table 2 Statistics of six visible light vegetation indexes based on region of interest

植被指数

Vegetation index果树 Fruit tree 非果树 Non fruit tree 平均值

Mean标准差

Standard deviation平均值

Mean标准差

Standard deviation超红指数 Excess red index −27.293 4 11.959 8 46.642 1 30.383 9 超绿指数 Excess green index 115.230 7 25.873 2 9.023 5 18.045 8 超蓝指数 Excess blue index −39.266 7 15.487 6 44.257 4 28.460 9 可见光波段差异植被指数 Visible band differential vegetation index 0.339 2 0.087 9 0.021 8 0.046 3 红绿比指数 Red-green ratio index 0.532 7 0.097 3 0.960 9 0.119 6 蓝绿比指数 Blue-green ratio index 0.466 5 0.104 1 0.960 5 0.130 6 表 3 6种可见光植被指数的植被提取精度评价

Table 3 Accuracy assessments of vegetation extraction for six visible light vegetation indexes

植被指数

Vegetation index阈值

Threshold精度/% Accuracy Kappa系数(K)

Kappa coefficient果树

Fruit tree非果树

Non fruit tree总体

Total超红指数 Excess red index −1.886 99.78 90.63 95.18 0.903 6 超绿指数 Excess green index 50.000 99.68 87.58 93.60 0.872 0 超蓝指数 Excess blue index −4.675 99.77 94.62 97.18 0.943 6 可见光波段差异植被指数

Visible band differential vegetation index0.133 99.98 88.28 94.10 0.882 0 红绿比指数 Red-green ratio index 0.724 99.84 89.25 94.52 0.890 4 蓝绿比指数 Blue-green ratio index 0.682 99.79 91.40 95.57 0.911 4 表 4 6种可见光植被指数融合数字表面模型提取精度评价

Table 4 Accuracy assessments of vegetation extraction for six visible vegetation indexes combined with digital surface model

植被指数

Vegetation index精度/% Accuracy Kappa系数(K)

Kappa coefficient果树 Fruit tree 非果树 Non fruit tree 总体 Total 超红指数 Excess red index 99.46 98.08 98.77 0.956 7 超绿指数 Excess green index 99.28 95.26 97.27 0.945 4 超蓝指数 Excess blue index 99.45 95.43 97.44 0.948 9 可见光波段差异植被指数

Visible band differential vegetation index99.76 95.58 97.67 0.953 4 红绿比指数 Red-green ratio index 99.31 96.37 97.84 0.956 8 蓝绿比指数 Blue-green ratio index 99.23 96.45 97.84 0.956 8 -

[1] 牛亚晓, 张立元, 韩文霆, 等. 基于无人机遥感与植被指数的冬小麦覆盖度提取方法[J]. 农业机械学报, 2018, 49(4): 212-221. doi: 10.6041/j.issn.1000-1298.2018.04.024 [2] GITELSON A A, KAUFMAN Y J, STARK R, et al. Novel algorithms for remote estimation of vegetation fraction[J]. Remote Sens Environ, 2002, 80(1): 76-87. doi: 10.1016/S0034-4257(01)00289-9

[3] YANG H B, ZHAO J, LAN Y B, et al. Fraction vegetation cover extraction of winter wheat based on spectral information and texture features obtained by UAV[J]. Int J Precis Agric Aviat, 2019, 2(2): 54-61.

[4] TAHIR M N, LAN Y B, ZHANG Y L, et al. Real time estimation of leaf area index and groundnut yield using multispectral UAV[J]. Int J Precis Agric Aviat, 2020, 3(1): 1-6.

[5] XU W, LAN Y, LI Y, et al. Classification method of cultivated land based on UAV visible light remote sensing[J]. Int J Agr Biol Eng, 2019, 12(3): 103-109.

[6] CHOI S K, LEE S K, JUNG S H, et al. Estimation of fractional vegetation cover in sand dunes using multi-spectral images from fixed-wing UAV[J]. Journal of the Korean Society of Survey, Geodesy, Photogrammetry, and Cartography, 2016, 34(4): 431-441. doi: 10.7848/ksgpc.2016.34.4.431

[7] ZHANG D, MANSARAY L R, JIN H, et al. A universal estimation model of fractional vegetation cover for different crops based on time series digital photographs[J]. Comput Electron Agr, 2018, 151: 93-103. doi: 10.1016/j.compag.2018.05.030

[8] 高永平, 康茂东, 何明珠, 等. 基于无人机可见光波段对荒漠植被覆盖度提取的研究[J]. 兰州大学学报(自然科学版), 2018, 54(6): 770-775. [9] MEYER G E, NETO J C. Verification of color vegetation indices for automated crop imaging applications[J]. Comput Electron Agr, 2008, 63(2): 282-293. doi: 10.1016/j.compag.2008.03.009

[10] WOEBBECKE D M, MEYER G E, VON BARGEN K, et al. Color indices for weed identification under various soil, residue, and lighting conditions[J]. Transactions of the ASAE, 1995, 38(1): 259-269. doi: 10.13031/2013.27838

[11] GUIJARRO M, PAJARES G, RIOMOROS I, et al. Automatic segmentation of relevant textures in agricultural images[J]. Comput Electron Agr, 2011, 75(1): 75-83. doi: 10.1016/j.compag.2010.09.013

[12] GAMON J A, SURFUS J S. Assessing leaf pigment content and activity with a reflectometer[J]. New Phytol, 1999, 143(1): 105-117. doi: 10.1046/j.1469-8137.1999.00424.x

[13] SELLARO R, CREPY M, TRUPKIN S A, et al. Cryptochrome as a sensor of the blue/green ratio of natural radiation in Arabidopsis[J]. Plant Physiol, 2010, 154(1): 401-409. doi: 10.1104/pp.110.160820

[14] PUREVDORJ T, TATEISHI R, ISHIYAMA T, et al. Relationships between percent vegetation cover and vegetation indices[J]. Int J Remote Sens, 1998, 19(18): 3519-3535. doi: 10.1080/014311698213795

[15] 赵德升, 毛罕平, 陈树人, 等. 杂草识别中背景分割方法的比较研究[J]. 农机化研究, 2009(11): 76-79. [16] 邓书斌, 陈秋锦. EVVI遥感图像处理方法[M]. 北京: 高等教育出版社, 2014: 204. [17] 王民, 樊潭飞, 贠卫国, 等. PFWG 改进的 CNN 多光谱遥感图像分类[J]. 激光与光电子学进展, 2019, 56(3): 031003. -

期刊类型引用(8)

1. 夏晶晶. 基于KNN神经网络的无人机作业操控系统研究. 农机化研究. 2024(07): 183-187 .  百度学术

百度学术

2. 文飞,莫嘉维,胡宇琦,兰玉彬,陈欣,陆健强,邓小玲. 基于卷积神经网络遥感图像的荔枝花期长势评估. 华南农业大学学报. 2023(01): 123-133 .  本站查看

本站查看

3. 曲福恒,李婉婷,杨勇,刘红玉,郝忠林. 基于图像增强和注意力机制的作物杂草识别. 计算机工程与设计. 2023(03): 815-821 .  百度学术

百度学术

4. 陈裕锋,冯佩雯,凌金生,张书琪,余振鹏,熊琳琳,刘洪,谢家兴. 基于无人机多光谱图像的水稻品种鉴定. 南京农业大学学报. 2023(05): 995-1003 .  百度学术

百度学术

5. 张楠楠,张晓,白铁成,袁新涛,马瑞,李莉. 基于无人机可见光影像的新疆棉田田间尺度地物识别. 农业机械学报. 2023(S2): 199-205 .  百度学术

百度学术

6. 曹英丽,赵雨薇,杨璐璐,李静,秦列列. 基于改进DeepLabv3+的水稻田间杂草识别方法. 农业机械学报. 2023(12): 242-252 .  百度学术

百度学术

7. 焦晋康,胡炼,陈高隆,涂团鹏,王志敏,臧英. 水田行间除草装置设计与试验. 农业工程学报. 2023(24): 11-22 .  百度学术

百度学术

8. 卢征. 国土资源数据整合下无人机低空遥感监测系统设计. 电子设计工程. 2022(13): 78-81+86 .  百度学术

百度学术

其他类型引用(5)

下载:

下载: