Fish feeding behavior recognition model based on the fusion of visual and water quality features

-

摘要:目的

提升工厂化水产养殖中鱼类摄食行为识别的准确度。

方法本研究提出一种基于视觉和水质特征融合的鱼类摄食行为识别模型 MC-ConvNeXtV2。为更好地捕捉不同聚集程度的全局特征和摄食行为的细节特征,在ConvNeXtV2-T的每个卷积阶段,引入空间区域感知的局部注意力机制(Context-aware local attention mechanism, Cloatt);为提高模型在高密度养殖下的行为识别性能,设计多模态特征融合模块(Multimodal feature fusion module,MFFM),以实现视觉特征与溶解氧、温度、pH等水质特征的自适应融合。在养殖密度为160尾/m3的大口黑鲈Micropterus salmoides养殖工厂中进行模型测试。

结果测试结果表明,对于鱼群4种摄食行为分类任务,MC-ConvNeXtV2模型的识别准确率、精确率和召回率分别为96.89%、96.34%和96.59%,比ConvNeXtV2-T分别提升了3.11、2.42和2.72个百分点。

结论本研究提出的鱼类摄食行为识别模型为智能化养殖管理提供了新思路。

-

关键词:

- 水产养殖 /

- 鱼类摄食行为 /

- 多模态 /

- ConvNeXtV2

Abstract:ObjectiveTo improve the accuracy of fish feeding behavior recognition in industrial aquaculture environment.

MethodA fish feeding behavior recognition model was proposed based on the fusion of visual and water quality features, namely MC-ConvNeXtV2. To better capture the global features of different aggregation levels and the detailed features of feeding behavior, a context-aware local attention mechanism (Cloatt) was introduced in each convolution stage of ConvNeXtV2-T. To improve the behavior recognition performance of the model in high-density aquaculture, a multimodal feature fusion module (MFFM) was designed to achieve adaptive fusion of visual features and dissolve oxygen, temperature, and pH of water quality features. The model test was conducted in a Micropterus salmoides culture factory with a culture density of 160 fish/m3.

ResultThe test results showed that for the task of four feeding behaviors classification of fish school, the recognition accuracy, precision and recall of MC-ConvNeXtV2 model were 96.89%, 96.34%, and 96.59%, respectively. Compared with ConvNeXtV2-T, these indicators increased by 3.11, 2.42, and 2.72 percentage points, respectively.

ConclusionThe proposed fish feeding behavior recognition model offers a new approach for intelligent aquaculture management.

-

Keywords:

- Aquaculture /

- Fish feeding behavior /

- Multimodal /

- ConvNeXtV2

-

在工厂化水产养殖中,饲料占养殖生产总成本50%以上[1]。鱼群的投喂策略通常依赖于养殖人员的经验,但经验式操作容易出现投喂过量或投喂不足问题。投喂过量不仅造成饲料的浪费,残留饲料还增加过滤系统的净水负担;而投喂不足会影响鱼的生长速度,导致个体大小不一,甚至出现自相残食现象,增加疾病风险[2-3]。鱼群的摄食行为强度直接反映鱼群摄食需求,可用于确定饲料用量。智能化的鱼类摄食行为识别可促进投喂设备的升级,实现饲料用量的有效控制[4-6]。

现有的鱼群摄食行为识别是基于机器视觉。陈明等[7]提取镜鲤鱼群摄食图像的颜色、形状和纹理等特征,使用Relief特征选择和XGBoost算法筛选摄食评价因子,并通过加权融合方法确定评价因子权重,最后评估鱼群摄食行为强度。Feng等[8]提出3D-ResNet-GloRe模型,用于分析鳟鱼鱼群摄食视频并进行四级行为分类,以评估摄食状态。Zhang等[9]提出一种基于MobileNetV2-SENet的方法,用以识别鱼群的摄食行为。这些基于视觉的方法在鱼类摄食行为识别任务上取得了一定进展,但其在实际应用中容易受到光照、鱼体色和水色等影响。为弥补这些不足,已有研究基于声学技术识别鱼类摄食行为。Du等[10]将鱼群摄食声音数据转化为梅尔谱图,提出基于MobileNetV3-SBSC轻量级模型对其进行识别,从而实现对鱼群摄食强度的量化。然而,声学设备成本高,且养殖工厂环境噪声干扰较多,限制了该技术的大规模应用。

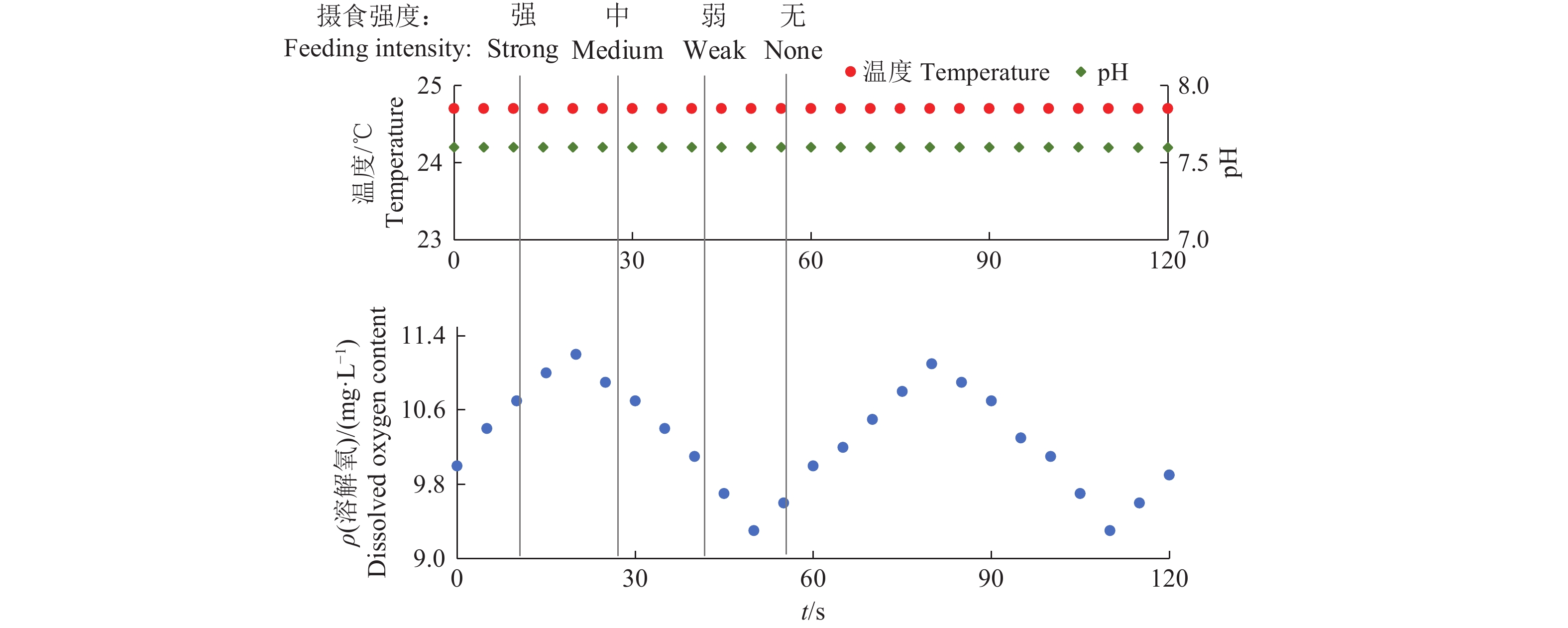

在工厂化水产养殖中,水质对于维持鱼类正常摄食至关重要。水质数据如溶解氧浓度、温度、pH等,会直接影响鱼的行为、食欲、繁殖和新陈代谢[11-12]。溶解氧浓度表现出非线性和时变性等特点,鱼的觅食和摄食行为引起水体流速的变化会影响局部水域中溶解氧浓度测量的变化[13]。温度会影响鱼的活动速度和新陈代谢,从而影响鱼类摄食行为。pH异常可能导致鱼的运动能力减弱、呼吸能力受损,进而影响食欲[14]。已有研究基于水质数据评估鱼类摄食行为。Wu等[13]通过量化溶解氧浓度变化与鱼类摄食需求的关系,提出一种自适应神经模糊推理系统(Adaptive neural-based fuzzy inference system, ANFIS)用于银鲈投喂决策。Liu等[15]开发了一个大口黑鲈精准投喂系统,通过实时采集养殖池水温度、溶解氧浓度和鱼类摄食行为强度等信息,实现动态调整投喂参数。因此,水质数据在一定程度上能够反映摄食状态。

随着多模态学习的兴起,利用多模态数据融合来提升模型性能成为研究热点。胡学龙等[16]在实验室养殖条件下提出了一种改进的Fish-MulT模型,通过融合行为、声音和水质数据对鱼类摄食行为进行分类,准确率相较于单模态方法至少提升3%。胥婧雯等[17]在实验室养殖环境下,提出了一种U-FusionNet-ResNet50+SENet模型,通过多级融合声音与视觉特征,提高了鱼类摄食行为识别准确率。

在工厂化水产养殖中,鱼体互相遮挡、水体颜色和光照等因素会影响基于机器视觉的模型对鱼类摄食行为进行识别。本研究提出一种MC-ConvNeXtV2鱼群摄食行为识别模型。在ConvNeXtV2-T[18]模型基础上,引入空间区域感知的局部注意力机制(Context-aware local attention mechanism, Cloatt)[19],以提高模型在高密度养殖条件下提取鱼群聚集程度特征和摄食行为细节特征的能力。同时,设计了1个多模态特征融合模块(Multimodal feature fusion module, MFFM),用于自适应融合图像和水质特征,并将其嵌入ConvNeXtV2-T的分类器之前,提升模型在高密度养殖条件下的识别性能。

1. 基于视觉和水质特征融合的鱼类摄食行为识别模型

1.1 模型网络结构

本研究提出一种基于视觉和水质特征融合的鱼类摄食行为识别模型MC-ConvNeXtV2,该模型由改进的ConvNeXtV2-T和多模态特征融合模块MFFM组成,其网络结构如图1所示。该模型输入为鱼类摄食过程中的图像和溶解氧含量、温度、pH水质数据。图像通过改进的ConvNeXtV2-T进行特征提取,同时水质数据经过4次多项式插值和线性层的处理,之后与图像特征一起输入MFFM模块中,生成融合特征。最后,融合特征通过分类器处理,输出鱼类摄食行为的强度。

在高密度养殖场景中,行为识别模型拥有更大的感受野有利于获取丰富的鱼类聚集和分散行为特征。ConvNeXtV2[18]是基于7×7卷积核的高效卷积神经网络,相较于使用3×3卷积核的传统网络,其感受野更大。ConvNeXtV2包括N、T、L等多个版本,每个版本的ConvNeXtV2块堆叠数量和通道数有所不同。ConvNeXtV2-T版本参数量适中,特征提取能力较强,本研究选用ConvNeXtV2-T作为视觉特征提取网络。

1.2 Cloatt注意力机制

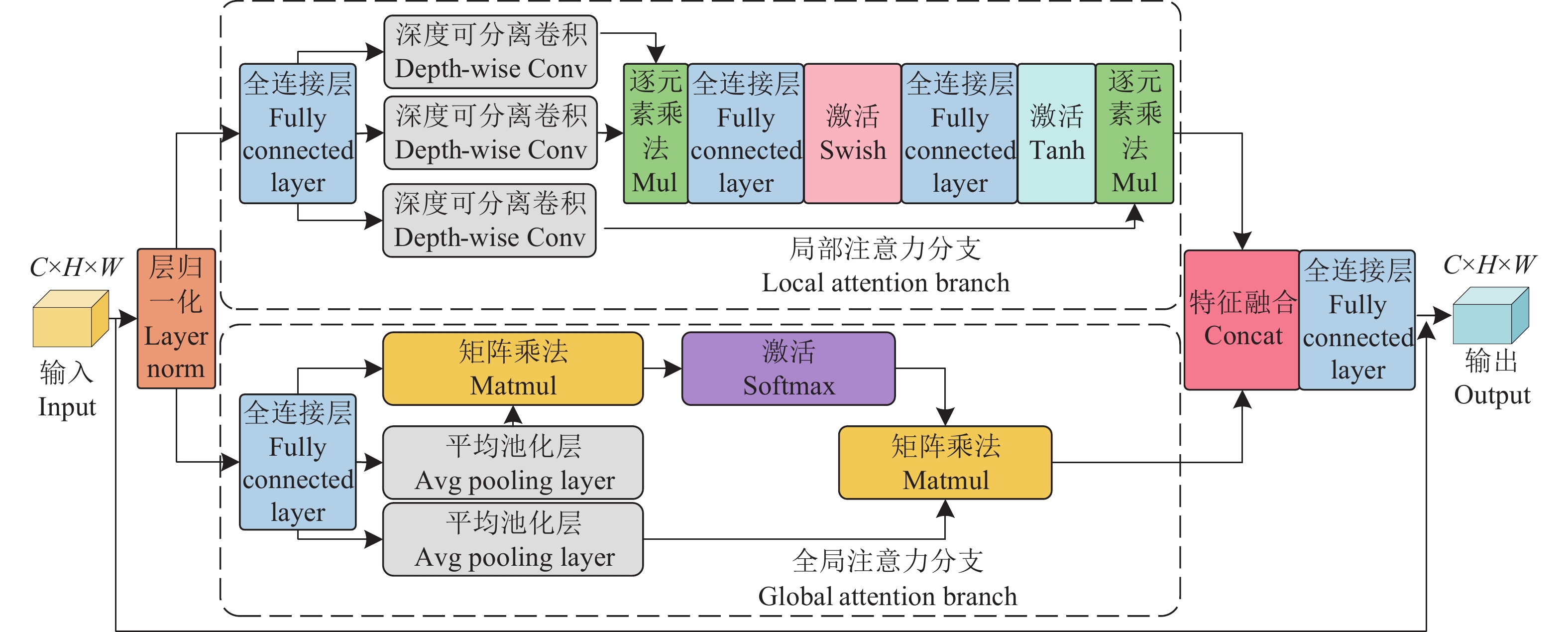

在工厂化水产养殖中,高密度养殖鱼群的摄食行为表现为聚集和分散,不同强度的摄食行为具有不同的空间分布和聚集程度。为更好提取鱼群空间特征和摄食细节特征,本研究将 Cloatt[19]引入ConvNeXtV2-T中。该模块的结构如图2所示。

Cloatt由2个并行的注意力分支组成,即全局注意力分支和局部注意力分支。全局注意力分支用于提取低频全局宏观特征,即鱼群整体分布、聚集程度和迁移趋势等宏观特征。局部注意力分支用于提取高频局部细节特征,即鱼群中个体或小规模群体的摄食行为细节特征。这种并行的注意力机制具有互补性,使得ConvNeXtV2-T在处理高密度养殖场景下的鱼类摄食行为时,能够同时兼顾低频全局宏观特征和高频局部细节特征,从而提升模型对鱼类摄食行为识别的准确率和鲁棒性。

1.3 多模态特征融合模块

在鱼群摄食行为识别中,鱼体互相遮挡、水体颜色和光照等会影响视觉数据质量;而水质数据不受以上影响,且能一定程度上反映鱼群摄食状态。为提高模型的鱼类摄食行为识别性能,本研究设计1个MFFM模块,如图3所示。该模块通过自适应融合图像和水质特征,生成具有高度代表性的融合特征

${{\boldsymbol{F}}_{\text{i}}}$ 。鱼类摄食行为图像经过改进的ConvNeXtV2-T提取特征后,得到图像特征

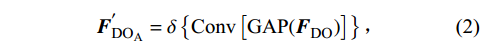

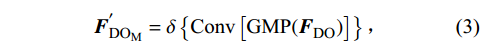

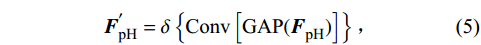

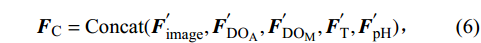

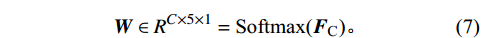

${{\boldsymbol{F}}_{{\text{image}}}}$ 。水质数据中各数据独立经过4次多项式插值后,得到水质特征分别为溶解氧特征${\boldsymbol{F}}_{\text{DO}} $ 、温度特征${\boldsymbol{F}}_{\text{T}} $ 和pH特征${{\boldsymbol{F}}_{{\text{pH}}}}$ 。首先对图像、温度和pH特征进行全局平均池化(Global average pooling, GAP)操作,以获得其全局特征表示。溶解氧含量具有非线性、大惯性、时变性等特点,本研究对其同时采用全局平均池化和全局最大池化(Global max pooling, GMP) 2种操作获取更全面的全局特征表示。然后,对各特征的全局特征表示进行1×1卷积操作,以建模特征通道间的相关性,并通过SiLU激活函数获得对应的通道描述向量。计算公式为:$$ {\boldsymbol{F}}_{{\text{image}}}^{{'}} = \delta \left\{ {\text{Conv} \left[ {\text{GAP} ({\boldsymbol{F}}_{{\text{image}}}^{})} \right]} \right\}{\text{,}} $$ (1) $$ {\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{A}}}}^{'} = \delta \left\{ {\text{Conv} \left[ {\text{GAP} ({\boldsymbol{F}}_{{\text{DO}}}^{})} \right]} \right\}{\text{,}} $$ (2) $$ {\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{M}}}}^{'} = \delta \left\{ {\text{Conv} \left[ {\text{GMP} ({\boldsymbol{F}}_{{\text{DO}}}^{})} \right]} \right\}{\text{,}} $$ (3) $$ {\boldsymbol{F}}_{\text{T}}^{'} = \delta \left\{ {\text{Conv} \left[ {\text{GAP} ({\boldsymbol{F}}_{{\text{T}}}^{})} \right]} \right\}{\text{,}} $$ (4) $$ {\boldsymbol{F}}_{{\text{pH}}}^{'} = \delta \left\{ {\text{Conv} \left[ {\text{GAP} ({\boldsymbol{F}}_{{\text{pH}}}^{})} \right]} \right\}{\text{,}} $$ (5) 式中,

$ {\boldsymbol{F}}_{{\text{image}}}^{'} $ 、$ {\boldsymbol{F}}_{{{\text{DO} }_{\mathrm{A}}}}^{'} $ 、$ {\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{M}}}}^{'} $ 、$ {\boldsymbol{F}}_{\text{T}}^{'} $ 和$ {\boldsymbol{F}}_{{\text{pH}}}^{{'}} $ $ \in {R^{C \times 1 \times 1}} $ ,${\boldsymbol{F}}_{{\text{image}}}^{'} $ 表示图像特征的通道表述向量,${\boldsymbol{F}}_{{{\text{DO} }_{\mathrm{A}}}}^{'} $ 表示溶解氧特征的平均通道描述向量,${\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{M}}}}^{'} $ 表示溶解氧特征的最大通道描述向量,${\boldsymbol{F}}_{\text{T}}^{'} $ 表示温度特征的通道描述向量,${\boldsymbol{F}}_{{\text{pH}}}^{{'}} $ 表示pH特征的通道描述向量,$\delta $ 为激活函数SiLU。通道描述向量的第1个维度表示向量的通道数。将5个通道描述向量在第2个维度上进行拼接,获得

${{\boldsymbol{F}}_{\text{C}}} \in {R^{C \times 5 \times 1}}$ 。通过Softmax激活函数获得代表自适应权重${\boldsymbol{W}}[:,i,:] \in {R^{C \times 1 \times 1}}$ ,计算公式为:$$ {{\boldsymbol{F}}_{\text{C}}} = \text{Concat} ({\boldsymbol{F}}_{{\text{image}}}^{{'}},{\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{A}}}}^{'},{\boldsymbol{F}}_{{\text{D}}{{\text{O}}_{\text{M}}}}^{'},{\boldsymbol{F}}_{\text{T}}^{'},{\boldsymbol{F}}_{{\text{pH}}}^{'}){\text{,}} $$ (6) $$ {\boldsymbol{W}} \in {R^{C \times 5 \times 1}} = {\text{Softmax(}}{{\boldsymbol{F}}_{\text{C}}}{\text{)}}{\text{。}} $$ (7) 将生成的权重乘以相应的输入元素,然后将特征相加,得到融合的特征表示

${{\boldsymbol{F}}_{\mathrm{i}}} \in {R^{C \times H \times W}}$ :$$ \begin{split} {{\boldsymbol{F}}_{\text{i}}} =\; &{\boldsymbol{W}}[:,0,:] \otimes {{\boldsymbol{F}^{{'}}}_{{\text{image}}}} + {\boldsymbol{W}}[:,1,:] \otimes {{\boldsymbol{F}^{{'}}}_{{\text{D}}{{\text{O}}_{\text{A}}}}} +\\&{\boldsymbol{W}}[:,2,:] \otimes {{\boldsymbol{F}^{{'}}}_{{\text{D}}{{\text{O}}_{\text{M}}}}} + {\boldsymbol{W}}[:,3,:] \otimes {{\boldsymbol{F}^{{'}}}_{\text{T}}} + \\&{\boldsymbol{W}}[:,4,:] \otimes {{\boldsymbol{F}^{{'}}}_{{\text{pH}}}}{\text{。}} \end{split} $$ (8) 2. 数据采集与处理

2.1 数据采集

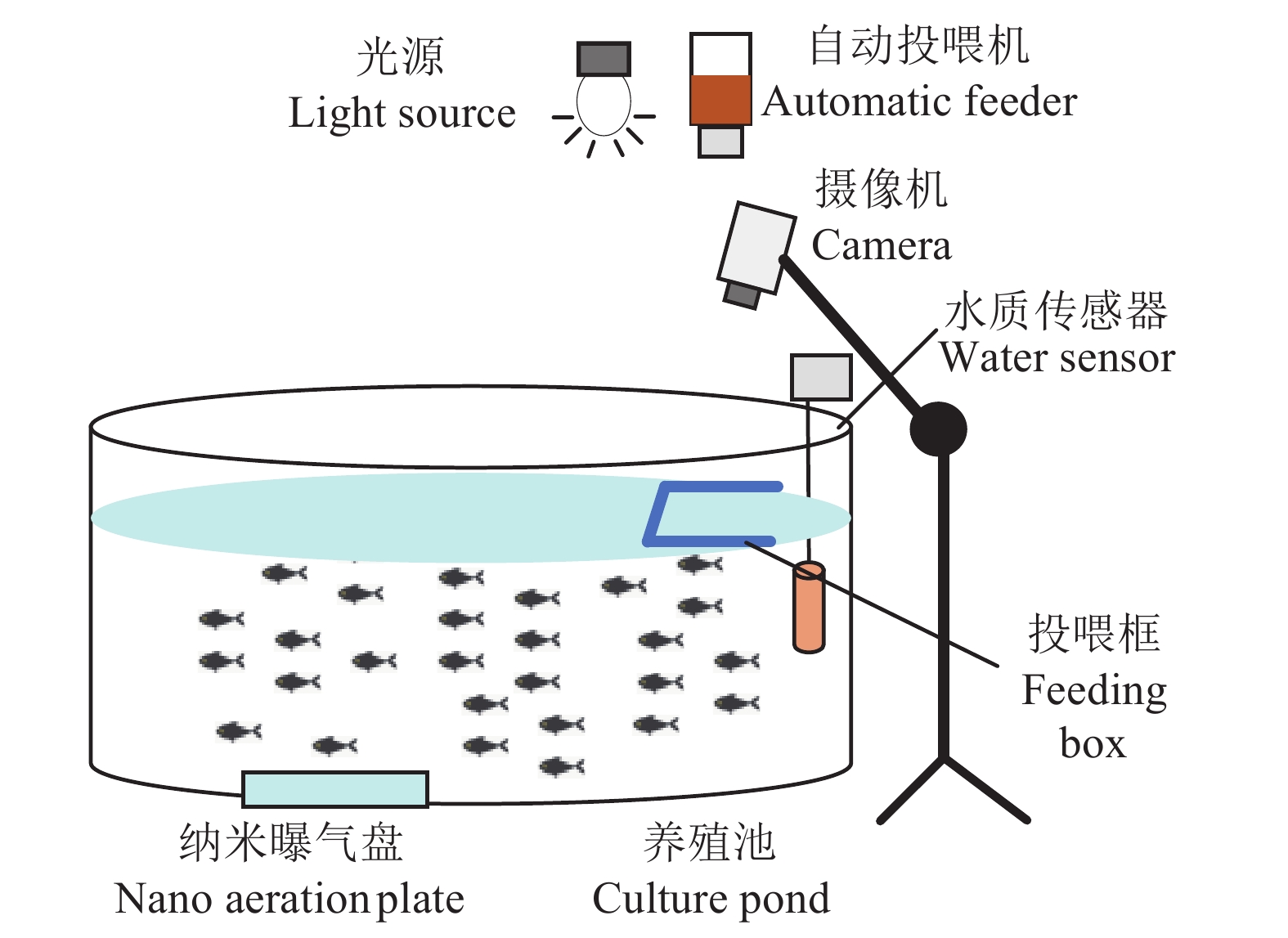

视频和水质数据采集自上海市崇明区生态水产养殖遗传育种研究中心的养殖工厂。养殖对象为大口黑鲈鱼Micropterus salmoides,养殖阶段为幼鱼阶段,养殖密度为160尾/m3。该鱼种具有较强的抢食性,其摄食行为表现为上浮至水面并迅速聚集至饲料处。该研究设计了视觉和水质数据采集系统,其原理如图4所示。数据采集系统的摄像机为工业无畸变摄像机,分辨率为

1920 像素×1080 像素,帧率为30帧/s,设置在距水面1.1 m处。溶解氧、温度和pH水质传感器布设在水面下30 cm处,每5 s采集1次数据。投喂框尺寸为1.00 m×0.65 m,固定在养殖池边一侧。投喂框可阻挡水面波纹和曝气气泡等干扰,并防止剩余饲料随水流漂散。养殖池底部设置纯氧纳米曝气板,曝气板和投喂框间隔一段距离,避免曝气气泡对摄像机拍摄与水质数据采集的影响。2.2 数据集制作

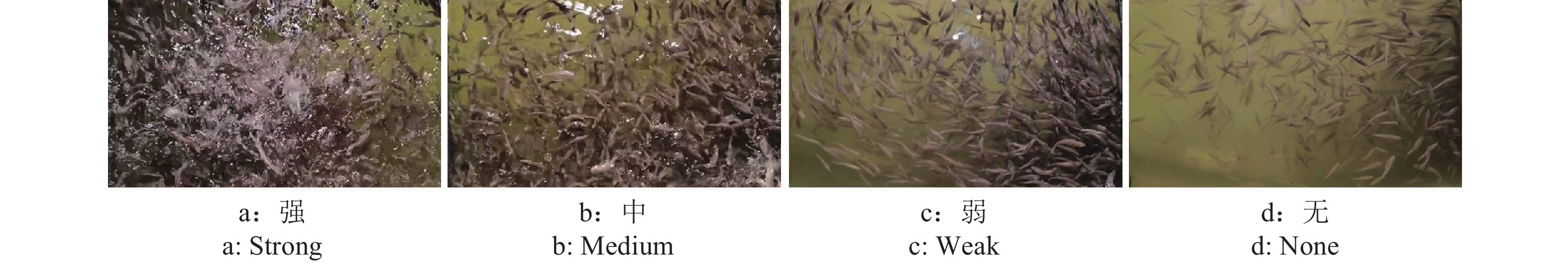

采集到的鱼类摄食行为视频按照摄食强度进行分类和抽帧。每隔2.5 s抽取1张鱼类行为图像。参考Øverli等[20]的方法将鱼类摄食行为分为4个等级,分别是“强”“中”“弱”和“无”。各等级鲈鱼鱼群摄食行为特点分别为:“强”,幼鱼迅速聚集,激起大量水花;“中”,少部分幼鱼离开聚集区,激起的水花渐少;“弱”,大部分幼鱼离开聚集区,水面几乎无激起的水花,水面波动小;“无”,鱼群无聚集行为,所有幼鱼缓慢游动,水面无波动。4个等级的鱼类摄食行为如图5所示。水质数据的变化曲线如图6所示。

本研究根据采集的图像和水质数据,共得到

7830 组2种模态数据,按照6∶2∶2的比例划分为训练集、验证集和测试集。数据集的最终构成如表1所示。表 1 摄食行为数据集划分Table 1. Feeding behavior dataset segmentation摄食强度

Feeding intensity训练集

Training set验证集

Validation set测试集

Test set总计

Total强 Strong 1168 389 389 1946 中 Medium 1153 385 385 1923 弱 Weak 1175 391 391 1957 无 None 1202 401 401 2004 总计 Total 4698 1566 1566 7830 2.3 图像预处理

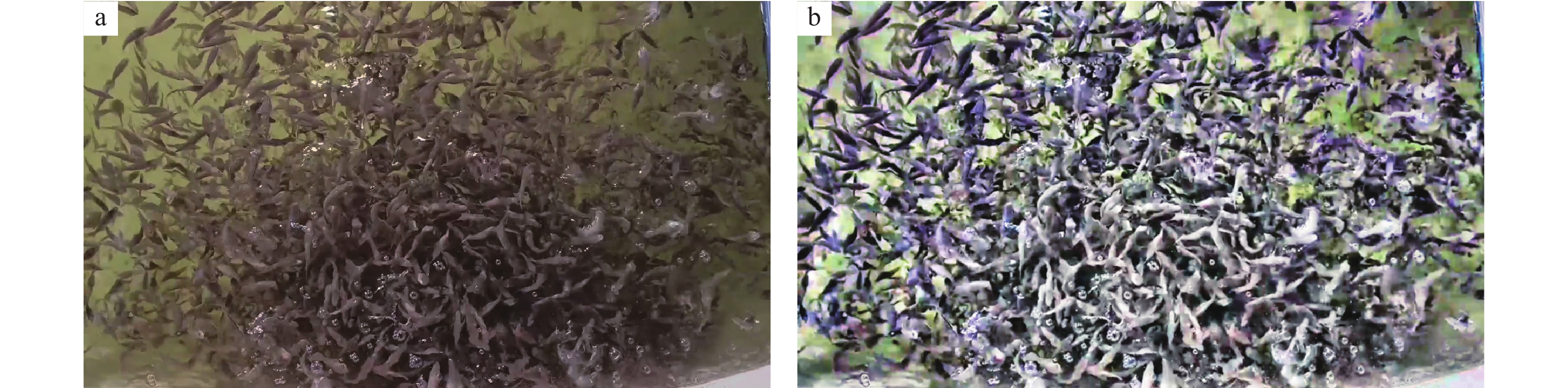

在整个摄食过程中,对输入图像进行等比例中心裁剪,保留鱼群的摄食行为区域。由于工厂化水产养殖中幼鱼养殖密度高,且幼鱼体色与水体颜色接近,给行为识别模型带来干扰。本研究使用高斯拉普拉斯(Laplacian of Gaussian, LoG)算子和对比度受限自适应直方图均衡化(Contrast limited adaptive histogram equalization, CLAHE)算法。预处理前、后的图像如图7所示。在预处理后的图像中,幼鱼与水体颜色对比度增大,边缘细节突出,有助于模型更精确地识别鱼类摄食行为。在进行模型训练过程中,对输入图像进行裁剪,接着进行图像预处理,最后将图像尺寸调整为224 像素×224 像素。

3. 模型测试与结果分析

3.1 试验环境

为验证本研究所提出模型的性能,在相同的硬件和软件平台下,将该模型与ResNet50、ResNet101和ConvNeXtV2-T等模型进行比较。试验硬件平台为英特尔Xeon(R)-W2223 CPU,32 G内存,英伟达RTX2080Ti显卡。试验的软件平台为:操作系统为Ubuntu20.04、Python版本为3.8和深度学习框架为PyTorch1.13.1。模型的训练超参数配置为:输入图像大小为224像素×224像素,批处理为16,学习率为

0.0001 ,优化器为Adam,训练轮数为150。3.2 评价指标

本研究中,使用精确率、准确率、召回率和F1值评估模型性能。精确率是预测为正确的单次摄食行为强度样本中的正确预测比例;召回率是实际标记为正确的单次摄食行为强度样本中的正确预测比例;F1值是精确率和召回率调和平均值。

3.3 模型训练

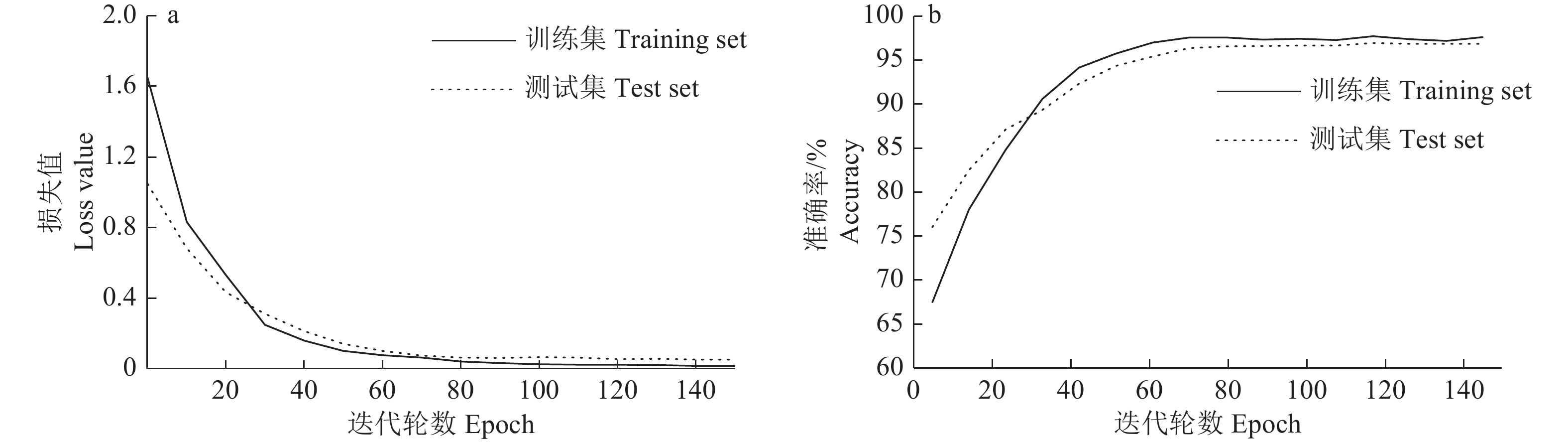

MC-ConvNeXtV2模型训练曲线如图8所示。模型训练的损失曲线在迭代90次左右趋于稳定,说明模型接近收敛。模型在测试集准确率达到96.89%。

3.4 消融试验

3.4.1 图像预处理对比试验

在本研究数据集制作中,对图像数据进行了预处理操作。为验证图像预处理操作的有效性,对提出的MC-ConvNeXtV2和ConvNextV2-T网络进行了比较,结果如表2所示。

表 2 图像预处理对比试验结果Table 2. Image preprocessing comparison experimental results模型

Model预处理

Preprocessing准确率/%

Accuracy精确率/%

Precision召回率/%

RecallF1值

F1 scoreConvNextV2-T 是 Yes 93.78 93.92 93.87 93.89 否 No 92.25 92.12 92.25 92.18 MC-ConvNeXtV2 是 Yes 96.89 96.34 96.59 96.46 否 No 93.81 93.36 93.13 93.24 在已预处理数据集上,MC-ConvNeXtV2和ConvNextV2-T表现的性能均优于在未预处理数据集上的表现。特别是MC-ConvNeXtV2的识别准确率提升了3.08个百分点。这是由于图像预处理操作在增强图像对比度的同时限制噪声,从而减少了水体颜色的影响,增强了鱼体对比度和边界,使模型学到丰富且清晰的特征,提高了模型性能。

3.4.2 MC-ConvNeXtV2模型的消融试验

对MC-ConvNeXtV2模型进行消融试验,结果如表3所示。

表 3 MC-ConvNeXtV2模型不同组件的消融研究Table 3. Ablation study of different components in MC-ConvNeXtV2模型

Model模态

Modality准确率/%

Accuracy参数量/(×107)

Parameters浮点运算量/(×1010)

FLOPsConvNeXtV2-T 视觉 Vision 93.78 2.782 2.233 ConvNeXtV2-T+Cloatt 视觉 Vision 95.12 2.785 2.244 MC-ConvNeXtV2 视觉+水质

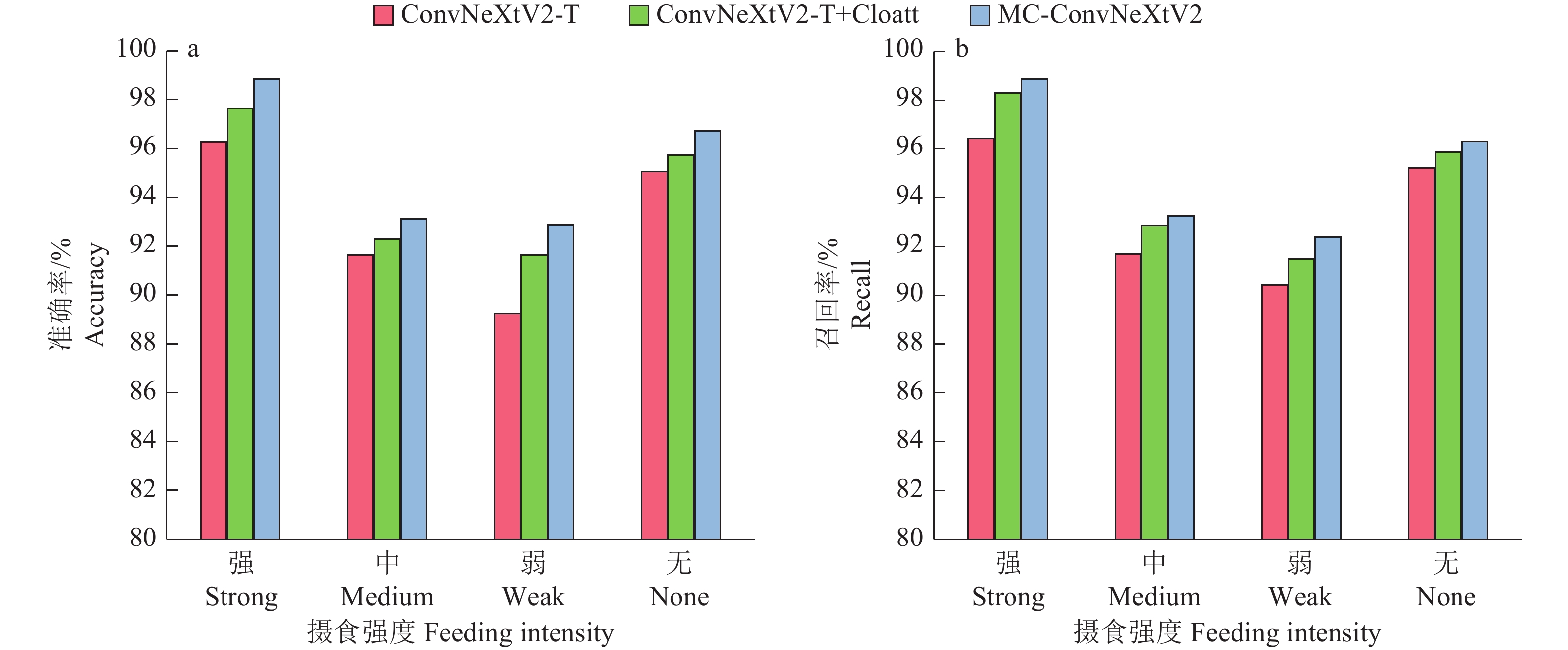

Vision + Water quality96.89 3.133 2.623 ConvNeXtV2-T+Cloatt模型较ConvNeXtV2-T模型准确率提高了1.34个百分点,仅增加了3.8×104参数量和1.1×108的浮点运算量。验证了Cloatt通过结合全局和局部特征,有效提升了模型对鱼类不同聚集程度特征和鱼类摄食行为细节特征的提取能力,且参数量和浮点运算量增加较少。MC-ConvNeXtV2模型较ConvNeXtV2-T模型准确率提高了3.11个百分点,验证了引入Cloatt和MFFM模块在融合图像和水质特征方面的有效性,提高了模型在高密度养殖下对鱼类摄食行为的识别准确率。对比3种模型在4种摄食强度上的准确率和召回率,结果如图9所示。

MC-ConvNeXtV2模型对4种摄食强度的识别准确率和召回率均为最高,所有指标均超过91%。Cloatt通过结合全局和局部特征,ConvNeXtV2-T+Cloatt模型较ConvNeXtV2-T模型对于“强”“中”“弱”和“无”摄食强度的识别准确率分别提高了1.39、0.64、2.39和0.70个百分点,验证了该模块可以增强模型提取鱼群聚集空间特征和摄食细节特征的能力。MC-ConvNeXtV2模型在“中”和“弱” 2个难以区分的类别上召回率优于其他模型,达到93.26%和92.38%,验证MFFM模块赋予模型多模态特征学习能力,使其在高密度养殖下表现良好。总体而言,MC-ConvNeXtV2在高密度养殖下对鱼类摄食行为识别表现良好。

3.4.3 视觉特征提取网络的对比试验

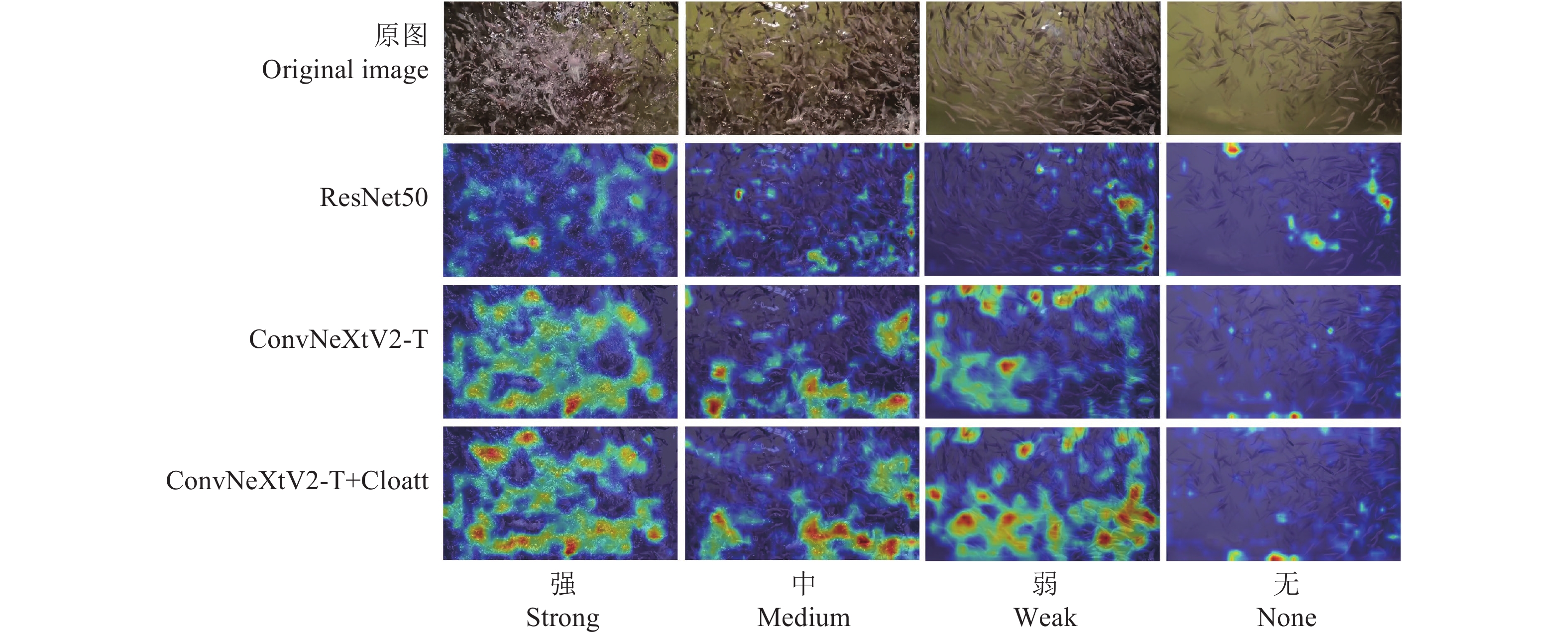

为验证视觉特征提取网络的有效性,将MC-ConvNeXtV2中的视觉特征提取网络与AlexNet[21]、ResNet50、ResNet101[22]、RepLKNet-31B[23]、ConvNeXtV2-T[18]进行替换,结果如表4所示。采用ResNet50、ConvNeXtV2-T、ConvNeXtV2-T+Cloatt作为视觉特征提取网络的模型输出热力图,如图10所示。

表 4 MC-ConvNeXtV2的视觉特征提取网络的对比试验Table 4. Comparative experiment on visual feature extraction network of MC-ConvNeXtV2视觉特征提取网络

Visual feature

extraction network准确率/%

Accuracy参数量/(×107)

Parameters浮点运算量/(×1010)

FLOPsAlexNet 89.21 4.941 0.369 ResNet50 91.13 3.417 2.496 ResNet101 92.82 5.317 4.724 RepLKNet-31B 95.49 8.584 9.252 ConvNeXtV2-T 95.12 3.131 2.612 ConvNeXtV2-T+Cloatt 96.89 3.133 2.623 试验结果表明,ConvNeXtV2-T+Cloatt作为视觉特征提取主干网络准确率达到96.89%,在所有对比网络中表现最佳。该模型相较于AlexNet、ResNet50、ResNet101[22]、RepLKNet-31B[23]和ConvNeXtV2-T[18]分别提高了7.68、5.76、4.07、1.40和1.77个百分点。AlexNet由于网络结构相对简单,难以有效捕捉复杂的鱼类摄食行为特征。ResNet50的热力图显示,其对鱼群摄食的动作和背景特征区分度较低,存在大量噪声干扰。RepLKNet-31B是基于31×31的超大卷积核的网络,虽然扩大了感受野,但显著增加了模型的参数量和浮点运算量,使其在工厂化水产养殖中应用受到限制。ConvNeXtV2-T采用7×7卷积核,相比于AlexNet、ResNet50、ResNet101,给模型提供更大感受野。通过对比ResNet50和ConvNeXtV2-T+Cloatt热力图,ConvNeXtV2-T+Cloatt不仅能够有效提取聚集行为和鱼类摄食细节特征,而且目标区域的热力图颜色强度更明显。验证了引入Cloatt使模型能够结合全局和局部信息,有效区分鱼类行为与背景,降低噪声干扰。同时,Cloatt模块具有轻量化的特点,因此在提升特征提取能力的同时,增加的参数量和浮点运算量较少。综上,ConvNeXtV2-T+Cloatt作为视觉特征提取网络,在识别准确率上表现突出,而且计算资源开销相对较小,适合在工厂化水产养殖中应用。

3.5 不同模型对比试验结果

为评估MC-ConvNeXtV2的鱼类摄食行为识别性能,本研究选择AlexNet、ResNet50、ResNet101、RepLKNet-31B和ConvNeXtV2-T在自制的数据集上进行对比试验,结果如表5所示。

表 5 模型对比试验结果Table 5. Model comparison test results模型

Model模态

Modality准确率/%

Accuracy参数量/(×107)

ParametersAlexNet 视觉 Vision 85.44 4.534 ResNet50 视觉 Vision 89.63 2.350 ResNet101 视觉 Vision 91.72 4.249 RepLKNet-31B 视觉 Vision 94.33 7.884 ConvNeXtV2-T 视觉 Vision 93.78 2.782 MC-ConvNeXtV2 视觉+水质 Vision + Water quality 96.89 3.133 试验结果表明,MC-ConvNeXtV2的测试准确率相对于ResNet50、ResNet101、RepLKNet-31B和ConvNeXtV2-T分别提高7.26、5.17、2.56和3.11个百分点。其中,RepLKNet-31B与ConvNeXtV2-T均是基于大卷积核的卷积神经网络,且在摄食行为分类任务上表现良好。具体而言,RepLKNet-31B采用超大卷积核,识别准确率优于ConvNeXtV2-T,但模型的参数量高于其他对比模型。MC-ConvNeXtV2通过高效的图像特征提取和水质数据特征融合,提高模型识别准确率。在实际工程应用中,选择一个识别精度较高且参数量和浮点运算量适中的模型,有利于降低模型训练成本和设备硬件成本。

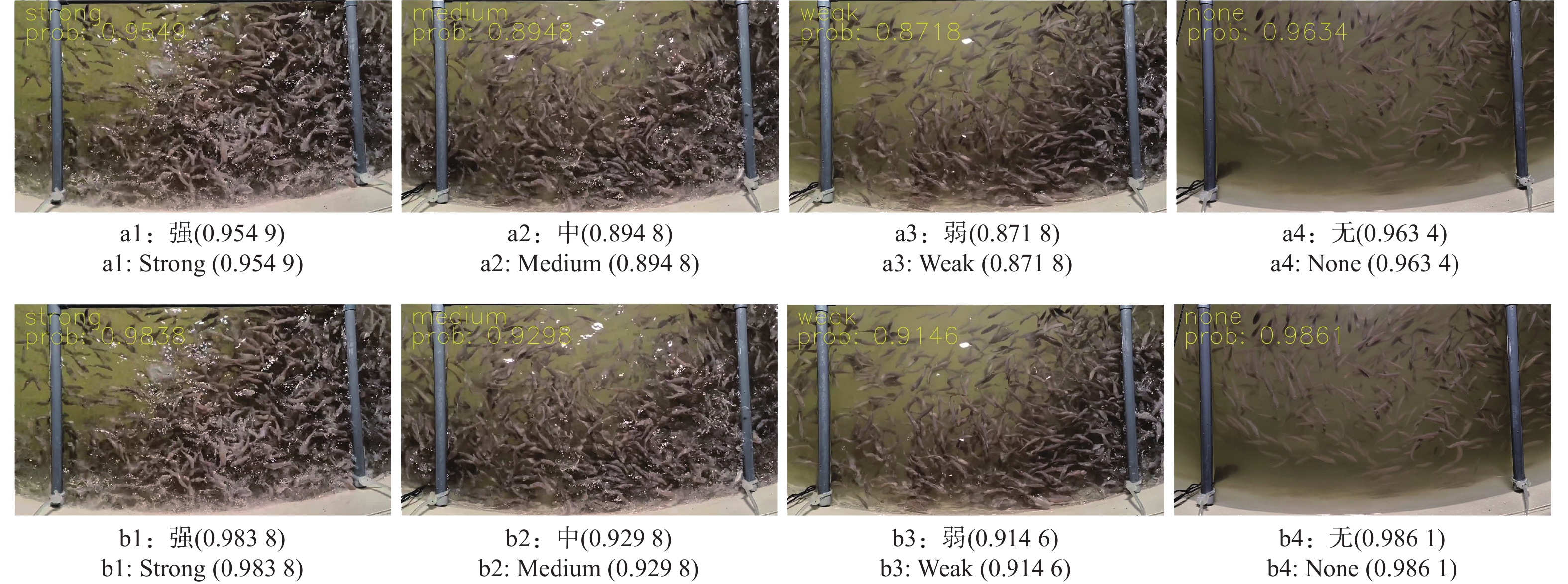

对比表4与表5的试验结果,上述卷积神经网络模型在添加MFFM模块后,各模型的识别准确率均有所提升,验证了MFFM模块使模型有效结合图像和水质特征。为进一步观察和分析模型的效果,本研究随机从4种摄食强度中各抽取1个样本进行识别,检测结果如图11所示。通过显示每个样本的置信度分数来评估模型的性能,置信度分数表示模型预测该样本属于某一类别的概率。结果表明,MC-ConvNeXtV2相较于ConvNeXtV2-T在4种摄食强度的置信度分数均有提高。这表明Cloatt模块能帮助模型有效提取鱼群摄食行为特征,而MFFM模块能够有效结合图像和水质数据的特征,最终实现识别准确率的提升。

4. 结论

本研究提出了一种基于视觉和水质特征融合的鱼类摄食行为识别模型MC-ConvNeXtV2。该模型通过引入Cloatt,有效融合全局宏观特征和局部细节特征,提升模型捕捉不同聚集程度的全局特征和摄食行为的细节特征的能力。通过消融试验验证了Cloatt提升模型性能的作用。本研究设计了多模态特征融合模块MFFM,实现了视觉和水质特征的自适应融合,提高模型在高密度养殖下鱼类摄食行为的识别准确率。本研究设计了视觉和水质数据采集系统,基于该系统收集的数据构建了一个鱼类摄食行为数据集。在该数据集上进行了MC-ConvNeXtV2模型的系列试验,其中摄食强度分类的识别准确率、精确率和召回率分别为96.89%、96.34%和96.59%,较ConvNeXtV2-T分别提升了3.11、2.42和2.72个百分点,F1值为96.46,提升了2.57。同时,该模型的识别准确率相较于ResNet50、ResNet101和ConvNeXtV2-T等模型均有提升,表明该模型在鱼类摄食行为识别中具有良好性能。未来工作中,需进一步探索鱼类在不同生长阶段和环境下的摄食行为特征;研究半监督学习在识别模型中的应用,拓展模型的泛化性能、减少数据标注需求和降低模型维护成本。

-

表 1 摄食行为数据集划分

Table 1 Feeding behavior dataset segmentation

摄食强度

Feeding intensity训练集

Training set验证集

Validation set测试集

Test set总计

Total强 Strong 1168 389 389 1946 中 Medium 1153 385 385 1923 弱 Weak 1175 391 391 1957 无 None 1202 401 401 2004 总计 Total 4698 1566 1566 7830 表 2 图像预处理对比试验结果

Table 2 Image preprocessing comparison experimental results

模型

Model预处理

Preprocessing准确率/%

Accuracy精确率/%

Precision召回率/%

RecallF1值

F1 scoreConvNextV2-T 是 Yes 93.78 93.92 93.87 93.89 否 No 92.25 92.12 92.25 92.18 MC-ConvNeXtV2 是 Yes 96.89 96.34 96.59 96.46 否 No 93.81 93.36 93.13 93.24 表 3 MC-ConvNeXtV2模型不同组件的消融研究

Table 3 Ablation study of different components in MC-ConvNeXtV2

模型

Model模态

Modality准确率/%

Accuracy参数量/(×107)

Parameters浮点运算量/(×1010)

FLOPsConvNeXtV2-T 视觉 Vision 93.78 2.782 2.233 ConvNeXtV2-T+Cloatt 视觉 Vision 95.12 2.785 2.244 MC-ConvNeXtV2 视觉+水质

Vision + Water quality96.89 3.133 2.623 表 4 MC-ConvNeXtV2的视觉特征提取网络的对比试验

Table 4 Comparative experiment on visual feature extraction network of MC-ConvNeXtV2

视觉特征提取网络

Visual feature

extraction network准确率/%

Accuracy参数量/(×107)

Parameters浮点运算量/(×1010)

FLOPsAlexNet 89.21 4.941 0.369 ResNet50 91.13 3.417 2.496 ResNet101 92.82 5.317 4.724 RepLKNet-31B 95.49 8.584 9.252 ConvNeXtV2-T 95.12 3.131 2.612 ConvNeXtV2-T+Cloatt 96.89 3.133 2.623 表 5 模型对比试验结果

Table 5 Model comparison test results

模型

Model模态

Modality准确率/%

Accuracy参数量/(×107)

ParametersAlexNet 视觉 Vision 85.44 4.534 ResNet50 视觉 Vision 89.63 2.350 ResNet101 视觉 Vision 91.72 4.249 RepLKNet-31B 视觉 Vision 94.33 7.884 ConvNeXtV2-T 视觉 Vision 93.78 2.782 MC-ConvNeXtV2 视觉+水质 Vision + Water quality 96.89 3.133 -

[1] KLAHAN R, YUANGSOI B, WHANGCHAI N, et al. Biorefining and biotechnology prospects of low-cost fish feed on red Tilapia production with different feeding regime[J]. Chemosphere, 2023, 311: 137098. doi: 10.1016/j.chemosphere.2022.137098

[2] AN D, HAO J, WEI Y, et al. Application of computer vision in fish intelligent feeding system: A review[J]. Aquaculture Research, 2021, 52(2): 423-437. doi: 10.1111/are.14907

[3] ABIDI S F, KHAN M A. Evaluation of feeding rate based on growth, feed conversion, protein gain and carcass quality of fingerling Indian major carp, Atla catla (Hamilton)[J]. Aquaculture Research, 2014, 45(3): 439-447. doi: 10.1111/j.1365-2109.2012.03245.x

[4] 朱明, 张镇府, 黄凰, 等. 鱼类养殖智能投喂方法研究进展[J]. 农业工程学报, 2022, 38(7): 38-47. doi: 10.11975/j.issn.1002-6819.2022.07.005 [5] ALZUBI H S, AL-NUAIMY W, BUCKLEY J, et al. An intelligent behavior-based fish feeding system[C]//2016 13th International Multi-Conference on Systems, Signals & Devices (SSD). Leipzig, Germany: IEEE, 2016: 22-29.

[6] 汪小旵, 武尧, 肖茂华, 等. 水产养殖中智能识别技术的研究进展[J]. 华南农业大学学报, 2023, 44(1): 24-33. doi: 10.7671/j.issn.1001-411X.202204013 [7] 陈明, 张重阳, 冯国富, 等. 基于特征加权融合的鱼类摄食活动强度评估方法[J]. 农业机械学报, 2020, 51(2): 245-253. doi: 10.6041/j.issn.1000-1298.2020.02.027 [8] FENG S, YANG X, LIU Y, et al. Fish feeding intensity quantification using machine vision and a lightweight 3D ResNet-GloRe network[J]. Aquacultural Engineering, 2022, 98: 102244. doi: 10.1016/j.aquaeng.2022.102244

[9] ZHANG L, WANG J, LI B, et al. A MobileNetV2-SENet-based method for identifying fish school feeding behavior[J]. Aquacultural Engineering, 2022, 99: 102288. doi: 10.1016/j.aquaeng.2022.102288

[10] DU Z, CUI M, WANG Q, et al. Feeding intensity assessment of aquaculture fish using Mel Spectrogram and deep learning algorithms[J]. Aquacultural Engineering, 2023: 102345.

[11] CHANDRAMENON P, AGGOUN A, TCHUENBOU-MAGAIA F. Smart approaches to Aquaponics 4.0 with focus on water quality: Comprehensive review[J]. Computers and Electronics in Agriculture, 2024, 225: 109256. doi: 10.1016/j.compag.2024.109256

[12] ABDEL-TAWWAB M, MONIER M N, HOSEINIFAR S H, et al. Fish response to hypoxia stress: Growth, physiological, and immunological biomarkers[J]. Fish Physiology and Biochemistry, 2019, 45(3): 997-1013. doi: 10.1007/s10695-019-00614-9

[13] WU T H, HUANG Y I, CHEN J M. Development of an adaptive neural-based fuzzy inference system for feeding decision-making assessment in silver perch (Bidyanus bidyanus) culture[J]. Aquacultural Engineering, 2015, 66: 41-51. doi: 10.1016/j.aquaeng.2015.02.001

[14] 王迎伟. 盐度和pH对大口黑鲈幼鱼生长及生理状态和相关基因表达的影响[D]. 杨凌: 西北农林科技大学, 2023. [15] LIU X, DU K, ZHANG C, et al. Precision feeding system for largemouth bass (Micropterus salmoides) based on multi-factor comprehensive control[J]. Biosystems Engineering, 2023, 227: 195-216. doi: 10.1016/j.biosystemseng.2023.02.005

[16] 胡学龙, 朱文韬, 杨信廷, 等. 基于水质−声音−视觉融合的循环水养殖鱼类摄食强度识别[J]. 农业工程学报, 2023, 39(10): 141-150. doi: 10.11975/j.issn.1002-6819.202302041 [17] 胥婧雯, 于红, 张鹏, 等. 基于声音与视觉特征多级融合的鱼类行为识别模型U-FusionNet-ResNet50+SENet[J]. 大连海洋大学学报, 2023, 38(2): 348-356. [18] WOO S, DEBNATH S, HU R, et al. ConvNeXt V2: Co-designing and scaling ConvNets with masked autoencoders[C]//2023 IEEE Conference on Computer Vision and Pattern Recognition. Vancouver, BC, Canada: IEEE, 2023: 16133-16142.

[19] FAN Q, HUANG H, GUAN J, et al. Rethinking local perception in lightweight vision transformer[EB/OL]. arXiv: 2303.17803 (2023-06-01) [2024-10-05]. https://doi.org/10.48550/arXiv.2303.17803.

[20] ØVERLI Ø, SØRENSEN C, NILSSON G E. Behavioral indicators of stress-coping style in rainbow trout: Do males and females react differently to novelty?[J]. Physiology & Behavior, 2006, 87(3): 506-512.

[21] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Advances in neural information processing systems. 2012: 1097-1105.

[22] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 770-778.

[23] DING X, ZHANG X, HAN J, et al. Scaling up your kernels to 31×31: Revisiting large kernel design in CNNs[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, LA, USA: IEEE, 2022: 11953-11965.

下载:

下载: